C’est un fait ! La meilleure façon de rentabiliser ses données dans le contexte de Big Data actuel consiste à distribuer le stockage des données et à paralléliser les traitements dans un cluster Hadoop. Hadoop est, aujourd’hui, suffisamment mature pour être considéré à grande échelle.

Hadoop-as-a-Service : comment ça marche ?

Hadoop-as-a-Service

Grâce à son intégration au SQL, il permet aux analystes de tirer profit des données de l’entreprise, qui résident encore pour la plupart, dans des systèmes opérationnels (ERP, Data Warehouse, bases de données de production, etc.).

Par ailleurs, en profitant de la baisse des coûts de stockage, le HDFS, qui est son système de fichiers, est devenu aujourd’hui l’option la plus profitable en termes de performance et de coûts financiers pour la constitution d’un Data Lake.

Rendre le coût de la DSI variable

La convergence du tissu économique vers le Numérique exige la flexibilité de la structure des coûts. Pour se réinventer, les entreprises doivent migrer d’une structure de coûts fixes à une structure de coûts variables. Or, on se souvient que l’infrastructure informatique représente l’une des plus importantes sources de charges fixes dans une entreprise et l’une des barrières à l’entrée les plus importantes dans l’économie de manière générale.

Malheureusement, malgré sa maturité, Hadoop demande un investissement important en termes de coûts financiers, ce qui n’est pas à la portée de toutes les entreprises. Pour profiter des effets de nouveaux business model permis par le Numérique, les entreprises doivent réussir à rendre le coût de leur DSI variable. Aujourd’hui, grâce au Cloud Computing, les entreprises ont l’opportunité de rendre variables les coûts de leur infrastructure informatique. Certains éditeurs ont réussi à offrir Hadoop selon un modèle de paiement à l’usage – Hadoop-as-a-Service (HaaS). Ce positionnement supprime la barrière à l’entrée que représentaient l’acquisition et la maintenance d’un cluster Hadoop et donne à toutes les entreprises indépendamment de leur taille ou leur budget, la possibilité de louer un cluster Hadoop sans s’encombrer des charges de maintenance. Dans cet article, nous vous expliquerons comment.

Pay-as-you-Go

Avant d’aller dans le détail de Hadoop-as-a-Service, il est important que vous compreniez bien ce que c’est que le Cloud Computing. Le Cloud Computing se définit selon deux aspects : un aspect économique et un aspect technique. Pour rester dans l’esprit de cet article, nous allons l’aborder uniquement d’un point de vue économique. Economiquement parlant, le Cloud Computing est un modèle économique dans lequel une entreprise appelée fournisseur Cloud offre comme produit un service Cloud via Internet.

Le service Cloud, ce sont des ressources informatiques pouvant représenter les ressources de la RAM, la puissance de Micro-processeur, la bande passante, un logiciel, une interface applicative, un environnement de développement, ou des clusters entiers d’ordinateurs. Ces services Cloud sont offerts sous forme de service Web, leur accès est contrôlé par une API et leur exploitation fait l’objet d’une facturation fonction du volume de ressources utilisées, par exemple le nombre de requêtes HTTPS adressées à l’API par minute, la puissance de calcul consommée par heure, la quantité de mémoire utilisée par semaine, etc.

A partir de cette configuration, les fournisseurs Cloud définissent des offres Cloud qui correspondent à des tarifications d’accès à des quantités précises de ressources dans un intervalle de temps, par exemple accès à 10 Go de disque dur à 4 euros/mois, accès à 1 ordinateur de 40Go de disque, 1 GHz Intel Dual Core de micro-processeur et 4 Go de RAM à 5 euros de l’heure. L’entreprise cliente sélectionne et s’abonne à l’offre Cloud qui correspond à ses besoins et paye à l’usage (c’est ce qu’on appelle une structure de coût « Pay-As-You-Go »). Elle peut se désabonner à tout moment, payant ainsi uniquement les ressources qu’elle a consommées. Ainsi, pour faire simple, le Cloud Computing est une forme de leasing (location) dans laquelle ce sont les ressources informatiques qui sont louées.

Téléchargez cette ressource

Guide inmac wstore pour l’équipement IT de l’entreprise

Découvrez toutes nos actualités à travers des interviews, avis, conseils d'experts, témoignages clients, ainsi que les dernières tendances et solutions IT autour de nos 4 univers produits : Poste de travail, Affichage et Collaboration, Impression et Infrastructure.

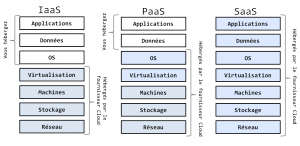

La taxonomie des services

Le Cloud permet aux éditeurs logiciels de transformer leurs infrastructures informatique (Serveurs, logiciels, applications) du livrable Standalone (ou On Premise) en services Web, mises à disposition de leurs utilisateurs au travers de terminaux connectés à Internet, selon la taxonomie IaaS, PaaS ou SaaS. L’image ci-dessous va vous permettre de comprendre clairement la taxonomie des services offerts en Cloud Computing et les niveaux de responsabilité partagées entre le fournisseur Cloud et le client à chaque type de service.

Taxonomie des services Cloud.

Les rectangles colorés correspondent aux ressources informatiques qui sont hébergées, maintenues et offerts en service par le fournisseur Cloud, tandis que ceux qui sont non-colorés correspondent aux ressources informatiques que l’entreprise cliente héberge et maintient chez elle.

En réalité, lorsqu’Hadoop est offert en Cloud, il peut être offert en deux options, soit l’IaaS pré-configuré, soit le Hadoop-as-a-Service

Le modèle Hadoop-as-a-Service

Dans cet article, nous allons rester sur le modèle HaaS. Comme son nom l’indique, dans cette option, Hadoop est offert comme un service Web. Des instances de service Hadoop sont facturées par le fournisseur. Une instance de service Hadoop est la combinaison d’une instance et d’une distribution Hadoop ou des composants spécifiques d’Hadoop directement installés sur ces instances.

Par exemple, le client peut acheter des instances Spark, qui correspondent à des instances de machine virtuelles avec des configurations précises sur lesquelles sont installées Spark, des instances Storm, des instances HBase, etc.

Ces instances sont automatiquement organisées en cluster complet (Nœuds de données et nœud de référence), scalable, et tolérant aux pannes par le fournisseur Cloud, ce qui vous évite de vous préoccuper de la mise en place, et de la mise en service du cluster et d’Hadoop vous-même.

Ce cluster peut s’approvisionner automatiquement en ressources si la charge de travail venait à dépasser la capacité de calcul du cluster. Le tableau suivant récapitule les caractéristiques principales de HaaS.

| Caractéristiques | Hadoop-as-a-Service |

| Offre Cloud | Instance de machine virtuelles à part + distribution/composant Hadoop + Object Store (optionnel) en un |

| Ressources Cloud | Instances de taille fixe au départ, mais qui se provisionnent automatiquement en cas de montée en charge et ce sans arrêt du service. Redimensionnement automatique |

| Facturation | Ressources des instances utilisées par période + composant Hadoop souscrit + volume de stockage souscrit (cas où il y’a eu souscription à un Object Store) ou Volume de Débit de données transférées (cas où il n’y’a pas eu souscription à un Object Store) |

| Indications | Recommandé si :

– Vous voulez travailler avec un composant spécifique de l’écosystème Hadoop ; – Vous voulez mettre en production des calculs qui demandent de la scalabilité, de la tolérance aux pannes et du redimensionnement automatique du cluster ; |

Tableau 1 : Caractéristiques principales du modèle Hadoop-as-a-Service

Voilà, vous connaissez maintenant l’essentiel en ce qui concerne l’utilisation d’Hadoop sous forme de service (Hadoop-as-a-Service).

Bien évidemment, vous vous doutez bien qu’il n’est pas possible de couvrir un sujet aussi vaste que le Cloud sous un aspect stratégique, économique et technique dans le même article.

C’est pourquoi, si vous souhaitez aller plus loin, nous vous recommandons l’ouvrage dont nous sommes auteur : « Maîtrisez l’utilisation des technologies Hadoop – Initiation à l’écosystème Hadoop », Juvénal Chokogoue ISBN 978-2-212-67478-1, éditions Eyrolles, Mai 2018.