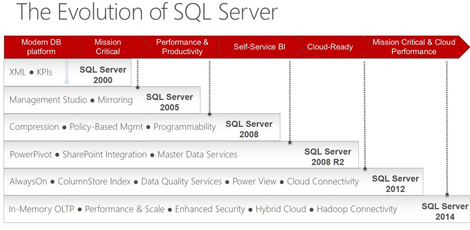

La nouvelle mouture de SQL Server est déjà sur les rails.

SQL Server 2014 fonce vers le temps-réel

Alors que l’édition 2012 a été lancée il y a 14 mois, Microsoft profite de sa convention TechEd pour annoncer son successeur.

Connu jusqu’à maintenant sous le nom de projet « Hekaton », le traitement transactionnel (OLTP) en mémoire sera intégré à la solution de base de données pour booster les performances applicatives et entrer dans l’ère du « business en temps-réel ».

Une intégration qui selon Microsoft couronne plusieurs années de travail et de collaboration entre les ingénieurs de la division Data Platform chez Microsoft et les chercheurs de Microsoft Research. « La puissance des processeurs modernes, la disponibilité, l’ampleur de la mémoire et l’avènement des disques SSD sont quelques-uns des changements architecturaux qui ont bousculé nos postulats sur le design des bases de données », explique Quentin Clark, Vice-président en charge de la Plateforme de donnés chez Microsoft.

Les utilisateurs n’auront toutefois besoin ni de hardware spécifique ni d’outils complémentaires pour utiliser les capacités de calcul In-Memory. Microsoft assure que ses clients pourront migrer directement leurs applications existantes vers la nouvelle plateforme pour en augmenter les performances.

Les liens avec Windows Azure seront également renforcés avec des fonctionnalités de sauvegarde, de plan de reprise après sinistre et de migration de machines virtuelles basées sur la plateforme Cloud de Microsoft. Ce, afin de favoriser la mise en place d’infrastructures hybrides. Des améliorations vont par ailleurs être apportées à Always-On, notamment pour le support de déploiements à grande échelle.

La firme de Steve Ballmer n’oublie pas de glisser un mot sur le Big Data qu’elle considère comme un des deux éléments fondamentaux qui ont piloté la conception de SQL Server 2014.

« L’intégration d’informations en temps-réel, les nouveaux formats et volumes de données, les signaux externes aux systèmes métiers, l’évolution des techniques d’analyse ou encore les expériences plus fluides de collaboration et de visualisation sont des éléments importants de cette transformation », indique Quentin Clark. Un changement que Microsoft propose d’accompagner grâce à la puissance de l’informatique en nuage, deuxième élément sur lequel sera axée la nouvelle plateforme. Plus de détails seront dévoilés avec la Preview prévue dans le courant du mois de juin.

Téléchargez cette ressource

Construire une infrastructure cloud optimisée pour l’IA avec Microsoft Azure

Les managers IT ont besoin d’une stratégie claire et de solutions concrètes pour préparer leur infrastructure cloud à l'adoption de l'IA, tout en optimisant les coûts, renforçant la sécurité et développant les compétences internes. Découvrez tous les conseils dans ce guide Insight.

Les articles les plus consultés

- Databricks lève 1 milliard de dollars !

- ActiveViam fait travailler les data scientists et les décideurs métiers ensemble

- Dark Web : où sont vos données dérobées ?

- 9 défis de transformation digitale !

- Stockage autonome, Evolutivité & Gestion intelligente, Pure Storage offre de nouvelles perspectives aux entreprises

Les plus consultés sur iTPro.fr

- Entamer la transition vers la cryptographie post quantique est prioritaire

- Full Cloud : une transformation numérique inévitable pour les entreprises ?

- Pilotage de la DSI : lucidité, exigences et engagement

- Les entreprises n’ont plus le luxe d’expérimenter l’IA

Articles les + lus

De la donnée brute à l’actif stratégique : une approche produit

L’essor de l’IA propulse les cyberattaques à des niveaux records

Face aux ransomwares, la résilience passe par les sauvegardes immuables

Les 6 tournants qui redéfinissent l’IA en entreprise

Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques

À la une de la chaîne Data

- De la donnée brute à l’actif stratégique : une approche produit

- L’essor de l’IA propulse les cyberattaques à des niveaux records

- Face aux ransomwares, la résilience passe par les sauvegardes immuables

- Les 6 tournants qui redéfinissent l’IA en entreprise

- Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques