par Herts Chen - Mis en ligne le 18/02/2004

Raccourcissez le temps de réplication instantanée et de configuration avec

cet outil d'automatisation

Quand vous appliquez la réplication

instantanée à de grandes bases de données,

l'étape qui supprime les enregistrements

cibles et celle qui copie en

bloc les données sources dans des

tables cibles indexées peuvent créer

deux goulets d'étranglement des performances...Quand vous appliquez la réplication

instantanée à de grandes bases de données,

l'étape qui supprime les enregistrements

cibles et celle qui copie en

bloc les données sources dans des

tables cibles indexées peuvent créer

deux goulets d'étranglement des performances.

Pour éliminer ces goulets d'étranglement - et donc optimiser la

réplication - vous pouvez ajouter des

étapes personnalisées aux jobs

Snapshot and Distribution Agent. Dans

le premier article de cette série en trois

parties, « Ouvrez la voie à la réplication

snapshot à grande échelle », octobre

2002, (ou sur www.itpro.fr), j'analysais la performance d'une réplication

instantanée et introduisais les

étapes personnalisées. Le deuxième article,

« Personnalisez votre réplication

instantanée à la main », janvier 2003,

(ou sur www.itpro.fr), détaillait l'implémentation

manuelle complète de ces

étapes. Dans cet article de conclusion,

voyons comment réaliser une personnalisation

rapide, fiable et reproductible

en utilisant SQL-DMO (SQL

Distributed Management Objects)

pour automatiser le processus de personnalisation.

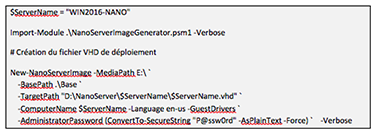

Pilote automatique

Optimiser la réplication instantanée

améliore considérablement les performances,

mais personnaliser manuellement

les jobs Snapshot and

Distribution Agent pour réaliser l’optimisation

peut s’avérer fastidieux et

long dans un environnement d’envergure

comportant de nombreux serveurs.

Comme il faut resynchroniser

manuellement la personnalisation

chaque fois que l’on pratique ces modifications,

il faut beaucoup de temps

quand on ajoute de nouvelles publications

ou qu’on reconfigure les existantes.

Manuellement, l’optimisation se

déroule ainsi. Vous essaierez une nouvelle

étape juste avant la dernière

étape du job Snapshot Agent. La commande

que cette étape exécute démarre

un job Distribution Agent. Vous

insérez ensuite deux nouvelles étapes

dans un job Distribution Agent, une

avant et une après son étape Run

Agent. L’étape avant abandonne tous

les index et les contraintes de clés par rapport aux tables d’abonnement.

L’étape après recrée les index et les

contraintes de clés que l’étape avant

avait abandonnés. La figure 1 montre

les quatre étapes du job Snapshot

Agent optimisé ; la figure 2 montre les

cinq étapes pour chaque job

Distribution Agent. Les nouvelles

étapes personnalisées sont l’étape 3

dans le job Snapshot Agent et les

étapes 2 et 4 dans le job Distribution

Agent.

$On voit donc que la personnalisation

manuelle dans Enterprise Manager

demande pas mal de travail : insérer

les nouvelles étapes, entrer des

commandes codées en dur ou une

procédure stockée pour exécution

dans chaque nouvelle étape et modifier

le flux des nouvelles étapes et les

étapes existantes affectées. Pis encore,

toute erreur ou incohérence introduite

pendant la personnalisation cassera

l’optimisation. Au lieu de vous enterrer

dans ces étapes manuelles fort

laborieuses, vous pouvez créer un outil

d’automatisation qui rendra votre processus

de personnalisation efficace,

homogène et reproductible. Cet outil

d’automatisation met en oeuvre les

tâches de personnalisation au moyen

de SQL-DMO.

Téléchargez cette ressource

Construire une infrastructure cloud optimisée pour l’IA avec Microsoft Azure

Les managers IT ont besoin d’une stratégie claire et de solutions concrètes pour préparer leur infrastructure cloud à l'adoption de l'IA, tout en optimisant les coûts, renforçant la sécurité et développant les compétences internes. Découvrez tous les conseils dans ce guide Insight.

Les articles les plus consultés

- Databricks lève 1 milliard de dollars !

- Stockage autonome, Evolutivité & Gestion intelligente, Pure Storage offre de nouvelles perspectives aux entreprises

- ActiveViam fait travailler les data scientists et les décideurs métiers ensemble

- Les projets d’intégration augmentent la charge de travail des services IT

- 10 grandes tendances Business Intelligence

Les plus consultés sur iTPro.fr

- Full Cloud : une transformation numérique inévitable pour les entreprises ?

- Pilotage de la DSI : lucidité, exigences et engagement

- Les entreprises n’ont plus le luxe d’expérimenter l’IA

- Le changement, moteur d’engagement au travail

Articles les + lus

De la donnée brute à l’actif stratégique : une approche produit

L’essor de l’IA propulse les cyberattaques à des niveaux records

Face aux ransomwares, la résilience passe par les sauvegardes immuables

Les 6 tournants qui redéfinissent l’IA en entreprise

Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques

À la une de la chaîne Data

- De la donnée brute à l’actif stratégique : une approche produit

- L’essor de l’IA propulse les cyberattaques à des niveaux records

- Face aux ransomwares, la résilience passe par les sauvegardes immuables

- Les 6 tournants qui redéfinissent l’IA en entreprise

- Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques