Platinum : un avenir doré pour Exchange ?

Microsoft fait tout son possible pour que Windows 2000 Server rencontre le succès du premier coup. Alors que le Gartner Group fait preuve de scepticisme en conseillant à ses clients d'attendre jusqu'en 2000 avant de déployer le nouvel OS, Microsoft a bien l'intention de persuader ses clients de migrer en veillant à ce que les applications les plus répandues fonctionnent bien sous Windows 2000 Server, notamment la nouvelle version d'Exchange Server. La prochaine version majeure du système de messagerie Microsoft Exchange (nom de code Platinum) ne tournera que sous Windows 2000 Server. Microsoft n'a pas encore fixé de date ferme pour sa sortie, mais ce sera dans tous les cas après Windows 2000.Platinum sera la version la plus stratégique d'Exchange et d'une envergure inégalée depuis les débuts la version 4.0 en 1996. Exchange 5.0 et 5.5 partaient d'une base établie par Exchange 4.0, qu'elles amélioraient et embellissaient, mais en conservaient le kernel. En revanche, Platinum comportera d'importantes modifications de certains composants majeurs d'Exchange Server. Pour vous permettre de préparer une éventuelle décision de passage à Platinum, je vais décrire les développements les plus significatifs du produit.

Lire l'article

Les performances d’Exchange 2000

Les caractéristiques de performances de Microsoft Exchange Server 5.5 sont bien

connues. En 1996, Exchange Server 4.0 a posé ses principes de base : atteindre

des performances optimales grâce à la distribution des fichiers et depuis, pas

grand-chose n'a changé. Microsoft a bien étendu la capacité de l'Information Store

(IS) jusqu'à la limite théorique de 16 To, mais le serveur de messagerie conserve

ses caractéristiques essentielles.

Dans Exchange Server, les points névralgiques, c'est-à -dire les fichiers générant

la plus lourde charge d'E/S, sont les bases de données de l'IS et du Directory

Store, leurs journaux de transactions, la copie sur disques de Windows NT et le

répertoire de travail MTA (Message Transfer Agent).

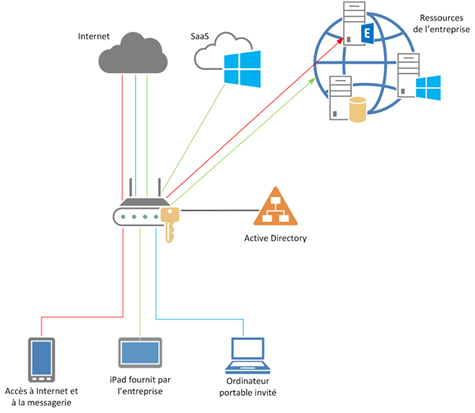

Exchange 2000 Server est d'un tout autre acabit. Le nouveau serveur de messagerie

bénéficie des améliorations suivantes :

* L'architecture de l'IS a nettement évolué, passant du simple partitionnement

de bases de données privées et publiques à un point où elle permet, théoriquement,

d'exécuter jusqu'à 90 bases de données sur un seul serveur.

* Microsoft IIS (Internet Information Server) traite tous les accès de protocoles

pour SMTP, IMAP4 (Internet Message Access Protocol), HTTP, NNTP (Network News

Transfer Protocol) et POP3, et joue donc un rôle plus important pour Exchange

2000 que pour les précédentes versions d'Exchange Server.

* Une nouvelle base de données déroulante peut contenir le contenu Internet natif.

* Active Directory (AD) de Windows 2000 remplace le Directory Store.

* Un nouveau moteur de routage et de mise en file d'attente, basé sur SMTP, remplace

l'ancien MTA basé sur X.400.

Ces améliorations font partie d'une solution customisable que les solutions tierces

étendront vraisemblablement pour doter Exchange 2000 de fonctions telles que antivirus,

fax, workflow, gestion de documents et autres fonctions qui ne font pas partie

du serveur de base.

Exchange 2000 apporte d'importants changements architecturaux affectant considérablement

les performances. Les concepteurs de systèmes vont devoir à présent se poser une

question cruciale : comment optimiser au maximum ces nouvelles fonctions en termes

de configurations systèmes et matériels.

Pour y répondre, commençons par examiner le partitionnement de l'IS d'Exchange

2000.Exchange 2000 apporte d'importants changements architecturaux affectant considérablement

les performances

Windows NT Terminal Server en action

Lorsque Microsoft a signé un accord avec Citrix pour acquérir la licence de WinFrame et développer l'édition Terminal Server de Windows NT Server 4.0, de nombreux observateurs se sont demandés comment ce nouveau produit allait changer la vie des utilisateurs de Windows NT. La réponse m'a été apportée par la pratique. La promesse, faite par Terminal Server, d'associer le meilleure des fonctions multiutilisateurs de WinFrame avec les fonctions et l'interface de NT 4.0 m'a semblé séduisante dès son annonce. Mais j'attendais l'occasion de tester Terminal Server dans la réalité pour voir comment il allait se comporter. Elle s'est présentée à moi récemment lorsqu'un de mes clients m'a appelé pour résoudre un problème. C'est Terminal Server qui m'a permis de le résoudre. Voici comment.

Lire l'article

Le SMP n’est plus seulement une affaire de serveurs

Lors de la sortie par Microsoft de Windows NT 3.5, j'ai décidé d'utiliser NT sur mon PC de bureau. J'en avais assez de la tendance de Windows 3.x à planter à des moments inopportuns et mon activité ne m'obligeait pas à exécuter des applications anciennes que NT ne pouvait pas traiter. Pour moi, cette migration était la bonne décision.

Lire l'article

La gestion des disques de Windows 2000

En général, j'ai le sentiment que les nouvelles versions des outils sont plus compliquées à utiliser que leurs prédécesseurs. Une croyance qui vient probablement de mes expériences passées et d'une tendance mainte fois observée. Pourtant, l'outil de gestion des disques de Windows 2000 évite le piège : le nouvel outil offre une interface simplifiée et compte de nouvelles fonctions très utiles.Les utilisateurs expérimentés de Windows NT sont des habitués de l'Administrateur de disques, l'outil intégré de NT pour la création, l'administration et la suppression des volumes logiques sur les disques physiques. L'équivalent Windows 2000 de l'Administrateur de disques de NT est le composant logiciel enfichable Gestion des disques que l'on peut démarrer depuis Outils d'administration, Gestion des disques (écran 1).

Lire l'article

Bâtir un site Web à haute disponibilité avec MSCS et IIS

Microsoft Cluster Server est un service précieux, mais méconnu, de Windows NT Server 4.0 édition Enterprise, qui augmente le temps de production grâce à une disponibilité élevée. Dans cet article, nous détaillerons les fonctions de base de MSCS et son utilisation avec Internet Information Server pour configurer un site Web à haute disponibilité.

Lire l'article

SSL et la cryptographie

Historiquement, SSL est un protocole mis au point par Netscape pour la sécurisation des communications sur le Web. Tous les acteurs du marché ont accepté ce protocole et le supportent, en attendant l'arrivée d'un standard international. Ce standard appelé TLS (Transport Layer Security), basé sur SSL, est mis au point par le l'IETF (Internet Engineering Task Force) et a été publié il y a peu de temps (TLS 1.0). Tous les éditeurs significatifs supportent ou ont annoncé leur intention de supporter TLS 1.0.Afin de comprendre ce qu'est SSL, il est indispensable de maîtriser les concepts de cryptographie qui en constituent les fondations.

Lire l'article

Optimiser les applications pour Terminal Server

L'un des aspects les plus épineux de l'installation d'un système informatique

basé sur les clients légers est de faire fonctionner pour plusieurs utilisateurs

des applications conçues pour un utilisateur unique. Windows NT Server 4.0 édition

Terminal Server risque donc de rencontrer des problèmes avec certaines applications.

Toutes les applications ne fonctionnent pas correctement en environnement multiutilisateur.

Certaines utilisent trop de cycles de processeur ou trop de mémoire, d'autres

ne savent pas s'il faut appliquer des paramètres à un utilisateur ou à un ordinateur,

et certaines stockent les informations dans des emplacements inadaptés à un OS

multiutilisateur.

Il arrive même de se retrouver bloqué par ces problèmes et, pour les applications

de ce type, de devoir les exécuter à partir de l'ordinateur client. Heureusement

certains problèmes peuvent se résoudre, à condition de leur consacrer un peu de

temps.Les applications ne fonctionnent pas toutes avec Terminal Server, mais les

astuces présentées ici vous aideront à tuner celles pour lesquelles c'est le cas.

Visite guidée de Babylone

Le tout dernier serveur d'interopérabilité d'entreprise, mis au point par Microsoft sous le nom de code Babylone, va remplacer SNA Server de la suite BackOffice et permettra, tout comme ce dernier, d'intégrer les réseaux Windows avec les mainframes et les AS/400 d'IBM. L'un des principaux objectifs de Microsoft pour Babylone est de se débarrasser des contraintes de SNA Server et d'englober totalement TCP/IP comme protocole réseau de base. L'objectif secondaire est d'approfondir le niveau d'intégration assuré par le serveur. Si Microsoft SNA Server assurait la connectivité de base des hôtes, Babylone passera, quant à lui, de la couche de connectivité de base au domaine de l'intégration des applications. Le tout nouveau serveur d'interopérabilité d'entreprise de Microsoft comprend beaucoup de nouvelles fonctions, dont certaines s'appuient sur les technologies actuelles de SNA Server, mais il lui manque malgré tout quelques pièces du puzzle de l'interopérabilité d'entreprise.

Lire l'article

Les stratégies de groupe

Microsoft affirme que la réduction du coût de possession est une des raisons de migrer vers Windows 2000. Le concept de TCO dépasse le simple prix d'achat de l'ordinateur et prend en compte bien d'autres centres de coûts, tels que le coût rémanent consistant à supporter le système et les utilisateurs. Quiconque a un jour travaillé à l'assistance aux utilisateurs, sait qu'en fixant des stratégies pour empêcher les utilisateurs de faire des modifications intempestives sur leurs systèmes, on peut éviter bien des problèmes pouvant affecter leur productivité et qui demandent fréquemment, pour les résoudre, l'intervention de personnels qualifiés. Dans Windows NT 4.0, les stratégies système sont à peine plus que des modifications du shell qu'un utilisateur averti peut contourner sans problème. En revanche, dans Windows 2000, Microsoft a développé considérablement la notion de stratégies systèmes. Détaillons les stratégies de groupe, principalement pour comprendre comment il fonctionne dans le modèle Active Directory (AD).

Lire l'article

Le Triangle d’Or

par Samy Mosimann Dans le monde de la banque privée, la place de l'AS/400 reste prépondérante, avec un facteur de 1 à 8 par rapport au nombre d'installations Unix Genève, Zurich et Luxembourg sont les trois sommets du triangle d'or de l'activité bancaire privée en Europe. Ces banques sont des établissements qui ne se comparent pas aux grandes banques nationales ou publiques européennes. Elles sont moins importantes et emploient de moins de 40 à plus de 500 employés. Globalement, on peut estimer qu'environ 1000 banques sont en activité dans ce domaine en Suisse et au Luxembourg.

Lire l'article

Sybase : une stratégie d’entreprise

Fondée en 1984, la société Sybase s'est rapidement fait connaître en tant qu'éditeur

de SGBDR. Les performances impressionnantes, la simplicité de mise en oeuvre et

la stabilité de SQLServer sont largement reconnues sur le marché. Sybase a acquis

une image de société à la pointe de la technologie grâce notamment à l'introduction

des procédures stockées et des triggers, aujourd'hui supportés par tous les grands

éditeurs de SGBD.

avec une simple station Sun, sans le moindre incident d'exploitation pendant des

mois (en ne redémarrant le serveur qu'une ou deux fois par an pour des mises à

jour du système d'exploitation).

Ce niveau de performance et de stabilité a permis à Sybase de conquérir rapidement

le marché bancaire et celui de l'assurance - les banques de Wall Street ont par

exemple presque toutes choisi ce SGBDR.

Après dix ans de croissance et de succès, Sybase a connu des revers et de sérieuses

difficultés pendant plusieurs années. Les difficultés n'étaient pas que financières

et les incidents de migration vers les nouvelles releases de Sybase se sont succédés.

Pendant cette période délicate la société a multiplié les nouveaux produits et

acquisitions de sociétés, sans réellement réussir à redresser la situation...

jusqu'à l'année dernière. Il faut remarquer que même au plus fort de la tempête

les clients traditionnels de Sybase n'ont pas abandonné et sont restés fidèles,

donnant ainsi au marché un signe clair de la confiance à long terme qu'ils avaient

dans la société et dans les produits.

A la fin de 1998, Sybase a effectué un redéploiement stratégique de ses produits

et profondément changé son approche du marché.

Ce bouleversement a été un véritable succès pour la société d'Emeryville. Sybase

a renoué avec les bénéfices en 1999 et fait cette année là un chiffre d'affaires

record de 872 M$. Après la pluie, le beau temps…

A la fin de 1998, Sybase a effectué un redéploiement stratégique de ses produits

et profondément changé son approche du marchéSybase est à présent restructuré

en quatre divisions : Internet Application Division (IAD), Information Anywhere

(I-Anywhere, anciennement MEC, Mobile Embedded Computing), Business Intelligence

(BI) et Enterprise Solution Division (ESD). Si cette dernière division (qui inclut

le traditionnel moteur de base de données) reste un pilier de la stratégie de

Sybase, l'évolution de la société vers le développement de solutions pour la Net-Economie

place la division IAD dans une position stratégique.

Des Clusters pour Windows NT

Pour les applications stratégiques de l'entreprise, les clusters sont le test

décisif pour mettre à l'épreuve un OS. Bien que les clusters Windows NT ne soient

pas encore très répandus, plusieurs éditeurs ont commencé à présenter des solutions,

qui viennent modifier significativement le paysage du clustering sous NT.

Selon les prévisions d'IDC (International Data Corporation), les entreprises mettront

en cluster 60 pour cent des serveurs NT existants en 2001. Microsoft Cluster Server

(MSCS) a fait son apparition dans NT Server 4.0, Enterprise Edition au début de

1998. C'était le projet Wolfpack, un cluster de type shared-nothing à 2 noeuds

assurant une bascule en cas de panne d'un serveur.

Pour l'instant, les constructeurs comme Compaq garantissent 99,9 pour cent de

temps de bon fonctionnement (c'est-à -dire seulement 8,76 heures d'indisponibilité)

par an pour MSCS. De par les 5 minutes nécessaires pour une réinitialisation,

MSCS peut prétendre à la haute disponibilité, mais on ne peut pas parler de criticité.

Je n'ai jamais admis l'argument de Microsoft selon lequel la majeure partie de

la clientèle de Microsoft peut se contenter de 8,76 heures de temps d'indisponibilité

par an.

Etant donné la lenteur laborieuse des progrès du clustering, MSCS sortira en version

2 noeuds dans Windows 2000 Advanced Server (AS). Mais la technologie de base du

clustering Microsoft est sur le point de faire un pas en avant significatif. D'ici

février 2000 Microsoft sortira une version de cluster à 4 noeuds basée sur MSCS

dans Windows 2000 Datacenter Server (Data Center).

Dans un cluster à 4 noeuds, les membres utilisent successivement la ressource partagée

qui définit le cluster (normalement un périphérique de stockage) et le cluster

n'a pas besoin d'une réinitialisation du système pour ré attribuer les ressources

lorsqu'un système membre tombe en panne. Les composants du cluster peuvent distribuer

la charge de travail d'un membre défaillant du cluster avec un équilibrage des

charges basé sur la redirection TCP/IP. Le cluster à 4 noeuds de Microsoft a donc

plus de capacités de clustering que le cluster à 2 noeuds.

La technologie de base du clustering Microsoft est sur le point de faire un pas

en avant significatif

Le clustering amélioré est une fonction majeure de Data Center. Avec l'extension

du support SMP à 32 processeurs, Data Center assurera une évolutivité et une tolérance

aux pannes que les grandes entreprises ne manqueront pas de considérer. Data Center

bénéficiera également de Process Control, nouvel outil de gestion basé sur la

technologie Job Object, développé par Microsoft conjointement avec Sequent Computer

Systems. Process Control permet de créer des règles pour gérer les ressources

applicatives dans les grands clusters de serveurs.

D'après les responsables du Clustering chez Microsoft, il existe trois architectures

de serveurs sur le marché : les clusters de serveurs, les clusters d'équilibrage

des charges du réseau et les clusters d'applications. Les clusters de serveurs

fournissent le failover lorsqu'un serveur cesse de reconnaître la pulsation du

cluster. MSCS appartient à ce type de cluster. Les clusters d'équilibrage des

charges de réseau ont un serveur maître qui distribue les requêtes aux serveurs

membres pour créer l'équilibre. Network Load Balancing (NLB) de Microsoft effectue

ce type de clustering sur 32 serveurs. Microsoft a basé NLB sur Convoy Cluster

de Valence Research qu'il a racheté.

Les clusters d'applications, également baptisés clusters d'équilibrage de charges

des composants, sont équipés d'un routeur équilibrant les charges des composants

COM+. Les clusters d'applications permettent la haute disponibilité au niveau

de la logique de gestion d'une solution de réseau distribuée.

A l'origine, Microsoft avait l'intention de faire des clusters d'applications

un élément de Data Center.

Cependant, le 13 septembre dernier, l'éditeur a annoncé qu'il sortira le clustering

des applications comme produit individuel baptisé AppServer

Microsoft a testé un cluster d'applications à 8 noeuds et sortira probablement

un cluster à 16 noeuds très prochainement.

Il existe trois architectures de clusters : disque partagé, disque en miroir et

shared nothing. Les clusters VAX et Oracle Parallel Server utilisent

Comprendre les contrôleurs de domaine

Windows NT Server organise les groupes d'ordinateurs en domaines, faisant en sorte que les machines d'un domaine partagent une base de données et une politique de sécurité communes. Les contrôleurs de domaine sont des systèmes sous Windows NT Server qui partagent la base de données centrale stockant les comptes des utilisateurs et leurs informations de sécurité pour un domaine. Lorsqu'un utilisateur se connecte à un compte de domaine, les contrôleurs de domaine authentifient le profil et le mot de passe de l'utilisateur en utilisant les informations de la base de données d'annuaire (également souvent baptisée base de données de sécurité de domaine ou base de données SAM). Pendant l'installation de Windows NT Server, vous devez désigner le rôle que chaque serveur devra tenir dans un domaine. NT vous offre le choix de 3 rôles : PDC (Primary Domain Controller - contrôleur principal de domaine), BDC (Backup Domain Controller - Contrôleur secondaire de domaine) et serveur membre. On crée un domaine dès lors que l'on désigne un PDC. Les PDC et BDC sont des éléments cruciaux des domaines. Pour garder le contrôle et tirer le meilleur des domaines que vous créez dans votre réseau NT, vous devez comprendre ce que sont les PDC et BDC, comment synchroniser la base de données d'annuaire entre PDC et BDC dans un domaine, comment promouvoir un BDC en PDC lorsque le PDC est indisponible, comment déterminer le bon nombre de PDC pour un domaine donné et comment gérer les relations d'approbation entre les PDC de différents domaines.

Lire l'article

Installer des logiciels avec Windows 2000

La gestion des postes de travail sous Windows NT est un cauchemar dans les grands environnements - et souvent dans les moins grands. Microsoft Systems Management Server (SMS) 2.0 règle en partie les problèmes d'administration, mais il lui manque certains composants essentiels ou certains sont mal adaptés aux grands environnements. Le problème de l'administration de système est le principal challenge de Microsoft. La prise en compte de ce problème et le coût considérable associé à sa résolution a débouché sur l'initiative Zero Administration for Windows (ZAW). Avec Windows 2000, Microsoft tente de faire passer ZAW de la théorie à la pratique et a même renommé l'ensemble des technologies Change and Configuration Management (CCM) - la gestion du changement et des configuration étant un objectif bien plus réaliste qu'un Windows sans administration ! Par exemple, Windows 2000 fournira des services pour améliorer l'installation et la configuration des logiciels. Dans cet article, nous verrons comment Windows 2000 permet de mieux gérer les applications des postes de travail et comment tout ceci s'intègre dans la stratégie globale de Microsoft.

Lire l'article

Le service de conférence d’Exchange 2000

De nombreux ingénieurs découvrent de nouvelles technologies lorsqu'ils doivent en administrer l'implémentation de Microsoft. Par exemple, de nombreux administrateurs sont devenus des experts de DNS en installant et configurant le serveur DNS de Windows NT 4.0. Ils ne se sont souvent renseigné sur les RFC de l'IETF et les autres implémentations de la technologies que plus tard. De même, ils seront nombreux à ne découvrir la conférence vidéo/données que maintenant que Microsoft se lance dans cette arène. Jusqu'à présent, le principal produit de Microsoft pour la visioconférence était NetMeeting. Certains fournisseurs de visioconférences ont intégré ce logiciel dans leurs produits, mais on peut utiliser le produits seul comme application stand-alone pour de petits besoins. Microsoft a doté Exchange 2000 Server (anciennement connu sous le nom de code Platinum) d'un service de conférence complet, dignes de concurrencer des systèmes d'entreprise coûtant des centaines de milliers de Francs. Pour utiliser ce nouveau service, vous devez comprendre ses fonctions et son architecture.

Lire l'article

Votre boutique d’e-commerce sécurisée avec SBS et Site Server

Microsoft Small Business Server (SBS) est un produit de choix non seulement pour les besoins de gestion des petites entreprises, mais aussi pour leurs sites Web de commerce électronique. Douze étapes pour construire votre boutique en ligne avec SBS et Microsoft Site Server 3.0 Commerce Edition. Microsoft a développé Site Server en le destinant principalement à des installations sur plate-forme BackOffice complète. Mais pour beaucoup de petites entreprises, utiliser seulement SBS et Site Server - plutôt que d'installer la solution BackOffice complète - est une idée séduisante. SBS et Site Server associés fournissent la majeure partie des fonctionnalités de BackOffice sans en atteindre le coût. Cependant, si SBS et Site Server sont faciles à installer et à configurer, le processus garantissant la sécurité de leur fonctionnement sur l'Internet n'est pas si simple.Cet article liste les étapes à respecter pour installer SBS, Site Server et les composants supplémentaires nécessaires pour sécuriser une solution de commerce électronique. Si vous suivez cette démarche, vous aurez une installation d'e-commerce SBS correctement sécurisée.

Lire l'article

10 trucs pour récupérer votre espace disques

La plupart des nouveaux systèmes Windows NT sont dotés de quantités prodigieuses d’espace disque local ; mais tout le monde n’a pas la chance d’utiliser un de ces monstres. Beaucoup d’entre nous gèrent des systèmes sur lesquels l’espace disque est un bien précieux. Ce mois-ci je vous fais part de quelques astuces pour récupérer l’espace disque dur.

Lire l'article

Comment clusteriser Exchange Server

Le clustering rend les plates-formes plus sûres, robustes et fiables pour les déploiements de messagerie. Mais Microsoft Exchange Server ne supportait pas cette fonction jusqu'à la sortie des éditions Entreprise de Windows NT Server 4.0 et d'Exchange Server 5.5. Farouche partisan des clusters depuis le VMSCluster de Digital, j'ai préféré attendre qu'Exchange supporte le clustering avant de l'adopter comme solution de messagerie. Après avoir cherché pendant deux mois le matériel adéquat, j'ai donc mis mon cluster Exchange Server en production en février 1998. La plupart du temps il tourne correctement et sans nécessiter beaucoup d'administration, mais sa mise en oeuvre a buté sur un certain nombre de problèmes et j'ai beaucoup appris en créant, configurant et maintenant un cluster Exchange l'an dernier.

Lire l'article

Référentiels : la course au jackpot

Les " référentiels "

(ou gisements de données) d'entreprise ont toujours été un produit difficile à

vendre. A leur niveau le plus élémentaire, ce sont des applications de bases de

données contenant des métadonnées, c'est à dire des données sur les données.

Dans le contexte des référentiels, le terme métadonnées désigne des informations

sur les actifs informatiques d'une organisation, depuis les définitions de composants

et les programmes COBOL jusqu'aux informations sur les data warehouses et les

datamarts on-line de l'entreprise. Les référentiels contiennent aussi généralement

des informations sur les schémas de base de données, les règles de gestion et

les conventions de codage et de noms de l'entreprise.

Il s'agit, en somme, d'une liste de ressources exhaustive, à indexage croisé,

un catalogue géant des ressources d'une organisation. Tel est l'objectif du référentiel

d'entreprise, il ne faut donc pas s'étonner si on les appelle parfois dictionnaires

ou encyclopédies de données.

Si cette description vous paraît trop abstraite, vous pouvez comparer le Registre

à un référentiel de tout ce que vous avez toujours voulu savoir sur un système

Windows.Vous êtes séduit par l'idée d'avoir un référentiel, mais, prudent, vous

pensez qu'il est probablement pénible à installer et à maintenir ? Vous n'avez

pas tort. Et nous revoici à la case départ : les référentiels sont depuis toujours

un produit difficile à vendre. Toutefois ils font malgré tout un come-back et

le moment est donc venu d'examiner ce qu'ils peuvent vous offrir.

Le marché actuel des référentiels est restreint et guère dynamique

Les plus consultés sur iTPro.fr

- Pourquoi Shopify Plus s’impose dans la transformation du e-commerce B2B

- Cybersécurité 2026 : Deepfakes, IA agentique et déficit de préparation

- Quand l’innovation échappe à ses créateurs: Comment éviter l’effet Frankenstein à l’ère de l’IA

- L’IA agentique, nouveau pilier de la résilience numérique des RSSI

Articles les + lus

Confiance et curiosité : les clés pour entrer (et grandir) en tant que femme dans la tech

Portails développeurs internes : accélérer l’innovation sans alourdir les budgets

Pourquoi Shopify Plus s’impose dans la transformation du e-commerce B2B

Quand l’innovation échappe à ses créateurs: Comment éviter l’effet Frankenstein à l’ère de l’IA

Alliée ou menace ? Comment l’IA redessine le paysage cyber

À la une de la chaîne Tech

- Confiance et curiosité : les clés pour entrer (et grandir) en tant que femme dans la tech

- Portails développeurs internes : accélérer l’innovation sans alourdir les budgets

- Pourquoi Shopify Plus s’impose dans la transformation du e-commerce B2B

- Quand l’innovation échappe à ses créateurs: Comment éviter l’effet Frankenstein à l’ère de l’IA

- Alliée ou menace ? Comment l’IA redessine le paysage cyber