L’évolution des technologies d’accès aux données

par Wei-Meng Lee - Mis en ligne le 18/12/02

Quand les premières bases de données

sont apparues, les développeurs

devaient connaître parfaitement celle

qu'ils utilisaient. Mais les produits et

les technologies touchant aux bases de

données ont progressé rapidement ... Des bases de données relationnelles

aux stockages de données non relationnelles,

comme le e-mail et les systèmes

de fichiers, les méthodes d'accès

aux données ont suivi le rythme

rapide de l'évolution technologique.

Aujourd'hui, face aux architectures

client/serveur et applications multi niveaux,

les développeurs doivent maîtriser

diverses technologies d'accès. La plupart d'entre eux ont, durant des années,

appris des sigles et des acronymes

comme ODBC, DAO, RDO, OLE

DB, ADO et RDS. Et voici que Microsoft

introduit le .NET Framework flanqué

d'une autre nouvelle technologie d'accès

aux données: ADO.NET.

En nous immergeant dans chaque

nouveau progrès, nous oublions souvent

comment la technologie d'accès

aux données a évolué et la logique et la

philosophie successives. Une bonne

compréhension de la progression -

d'ODBC à ADO.NET - peut vous aider

à choisir la technologie appropriée et à

l'optimiser pour votre organisation.

Ouvrez la voie à la réplication snapshot à grande échelle

par Herts Chen - mis en ligne le 18/12/02

Si vous êtes développeur d'applications

ou de bases de données, vous déplorez

probablement le temps excessif

que des utilitaires comme bcp (bulk

copy program), DTS (Data Transformation

Services) et la réplication

snapshot mettent pour copier une

quantité massive de données en plusieurs endroits ...Ainsi, un snapshot

d'une base de données contenant 500

Mo de données définies avec des

contraintes de clés et des index peut

durer 2 heures pendant la journée de

production ou 1 heure et demi la nuit,

pour effectuer un transfert entre deux

serveurs de bases de données haut de gamme, à quatre voies, avec 1 Go de

RAM et RAID 5. Cette performance est

inacceptable dans une ferme de serveurs

à équilibrage de charge 24x7 ou

dans un entrepôt de données d'entreprise

distribué dont le temps disponible

hors période de pointe est trop

court pour tolérer le transfert de multiples ensembles de données massifs

vers tous les serveurs. Mais alors,

comment peut-on accélérer la distribution

des données ?

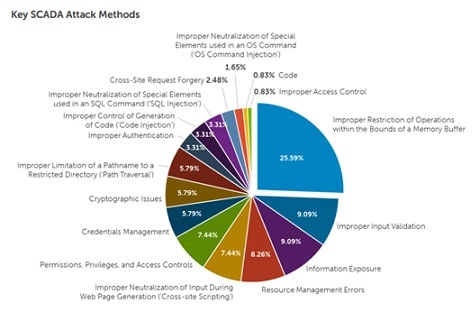

AppDetective for Microsoft SQL Server

Application Security annonce AppDetective for Microsoft SQL Server, solution qui analyse le réseau afin d'évaluer la sécurité des bases de données du réseau et des applications groupware.

Cette solution fournit des simulations d'attaque des bases de données et des audits de sécurité. AppDetective for Microsoft SQL Server supporte SQL Server 2000, 7.0 et 6.x.

Lire l'article

Rendre la BI accessible à tous types d’entreprises

par Catherine China - Mis en ligne le 05/02/2003

Depuis 1998, Microsoft est présent aux deux bouts de la chaîne de la Business

Intelligence (BI), tant côté serveur que client. C'est dans le développement

d'applications analytiques personnalisées qu'il voit l'avenir de la BI. Avec SQL Server

Accelerator for BI, son outil de développement rapide d'applications décisionnelles,

son objectif est de rendre la Business Intelligence accessible à tous types d'entreprises.Le point sur la stratégie BI de Microsoft avec John Eng, chef de produit US.

Plus de distorsion de données

par Dusan Petkovic et Christian Unterreitmeier - Mis en ligne le 09/07/2002

Des données faussées peuvent affecter le plan d'exécution des requêtes

contenant un prédicat et de celles

contenant une opération de jointure. Apprennez à tenir compte de la distorsion

des données pendant

la conception de la base de

données ...

Les colonnes d'une table représentent généralement les propriétés d'entités concrètes comme des noms d'employés et de produits. Quand votre requête contient un prédicat - une clause WHERE contenant des critères de recherche - incluant une colonne, l'optimiseur de requêtes SQL Server peut trouver les données correspondantes à la requête de deux manières différentes : balayage de table ou accès par index. Dans un balayage de table, l'optimiseur lit séquentiellement toutes les lignes d'une table et compare chacune d'elle aux critères de recherche de la clause WHERE. SQL Server décide en général de balayer toute la table quand la requête sélectionne un nombre significatif de lignes de la table. L'optimiseur de requêtes opte plutôt pour l'accès par index quand un index de colonne (clustered ou nonclustered) existe. Utiliser ou non l'index existant dépend de nombreux facteurs différents.

Lire l'article

DbEncrypt pour Microsoft SQL Server,

Application Security présente DbEncrypt pour Microsoft SQL Server, logiciel qui permet de crypter les lignes et colonnes de la base de données. Il est possible d'utiliser divers algorithmes de cryptage et une interface « pointer et cliquer » pour installer et gérer le cryptage.

DbEncrypt for Microsoft SQL Server fournit une interface qui génère des nombres aléatoires sécurisés et de solides clés de cryptage.

Lire l'article

Passez à SQL Server 2000

par Michelle A. Poolet et Michael D. Reilly - Mis en ligne le 09/07/2002

Si vous avez repoussé la mise à niveau

de vos anciennes bases de données

SQL Server 6.5, le moment est venu de

les amener dans le 21e siècle. Vous

pouvez sauter allègrement SQL Server

7.0 parce que SQL Server 2000 est la release

actuelle officielle et qu'elle regorge

de nouveautés ...

... Comme le SQL Server 2000 Upgrade Wizard vous fera passer de SQL Server 6.5 à 2000, autant court-circuiter SQL Server 7.0. Si vous utilisez déjà SQL Server 7.0, la mise à niveau n'en sera que plus simple. Pour plus de détails, voir l'encadré « Passer de SQL Server 7.0 à 2000 ».

Lire l'article

MSDE Primer for Access 2000

Complément de l'article "Interactivité entre le frontal Access et le moteur SQL Server"

Lire l'article

Tout sur la restauration

par Kalen Delaney - Mis en ligne le 26/11/2002

Restaurer une base de données SQL

Server après un sinistre est l'une des

missions les plus importantes d'un administrateur

système (sa, systems administrator).

Pourtant, la reprise fait

souvent l'objet de moins d'attention

que son opération jumelle, la sauvegarde ...

La plupart des administrateurs compétents savent qu'ils doivent sauvegarder régulièrement les données critiques. Aussi, comme la sauvegarde est généralement une opération plutôt simple, ils la confient souvent à un novice de l'équipe d'administration. Il n'y a d'ailleurs rien à y redire, tant que le débutant en question utilise une procédure rigoureuse.

En revanche, on confie rarement à des novices les opérations de restauration. Or, comme la restauration d'une base de données n'est pas une opération quotidienne, un administrateur de SQL Server peut fort bien gérer des bases de données pendant des années sans jamais faire une restauration d'urgence. Et donc, le jour où il doit procéder à une restauration après un sinistre, il n'est pas préparé à toutes les subtilités de l'opération. Des pépins inattendus dans la restauration peuvent vous obliger à consulter SQL Server Books Online (BOL) et la Microsoft Knowledge Base pour résoudre des problèmes, pendant que toute l'entreprise attend fièvreusement de pouvoir disposer à nouveau des données. Vous devez donc être prêt à affronter des problèmes inattendus et vous devez tester le plan de reprise. Si vous n'avez pas encore complètement testé vos opérations de reprise en simulant un scénario catastrophe, réfléchissez à une telle simulation dès que vous aurez fini de lire cet article. J'y passe en revue divers types d'opérations de sauvegarde, y compris des sauvegardes complètes, différentielles et du journal de transactions. Ensuite, j'explique les opérations de restauration de base et décris ce que SQL Server fait pendant qu'il restaure vos données. Dans de futurs articles, nous verrons les détails à connaître quand on transfère une base de données dans un nouvel endroit avec des utilisateurs différents. Nous verrons aussi les problèmes posés par la restauration de tout un système SQL Server au lieu d'une simple base de données d'utilisateurs.

Lire l'article

Can Generalists Handle Complex IT?

Complément de l'article "L'avenir du DBA" de la lettre SQL Server Vol.1 Num.3 - Juin 2002 (Pas encore mis en ligne)

Lire l'article

SQL Server 2000, Effectuez une installation efficace

par Itzik Ben-Gan - Mis en ligne le 26/11/2002

Microsoft s'efforce de simplifier au

maximum l'installation de son logiciel,

et SQL Server 2000 n'y fait pas

exception. A partir du CD-ROM

d'installation, on charge setupsql.

exe depuis le dossier x86\setup, on

renseigne quelques rubriques de

l'écran de dialogue setup et, dans

les minutes qui suivent, l'installation

se poursuit sans intervention de

l'utilisateur. On peut même installer

SQL Server 2000 sans rien comprendre

aux choix proposés, ...

... juste en cliquant sur Next dans la plupart des boîtes de dialogue setup. Mais ne prenez surtout pas l'installation à la légère : faites attention à chaque option et veillez à bien comprendre les implications et conséquences de chacun de vos choix. Certaines mauvaises décisions, comme un paramétrage de collation défectueux, pourraient être difficiles à rattraper. D'autres, comme le fait d'accepter l'authentification par défaut, pourraient bien mettre à mal la sécurité.

Voyons quelques points importants à propos de l'installation standard : configuration des instances, sécurité, collations, et Network Libraries. Ensuite, étudions les options avancées des installations, sans assistance et à distance. L'encadré « Reconstruire le registre » indique ce qu'il faut faire en cas de corruption des métadonnées de tables non système.

Lire l'article

Exporting a Table as an XML Document to a Web site

Complément de l'article "Interactivité entre le frontal Access et le moteur SQL Server"Let's look at an example that shows how to export a table as an XML document to a Web site. Let's start with a Microsoft Access project connected to the Pubs database, then export XML files for the authors table to a Web site on my intranet.

Lire l'article

Suite SQL Management 1.5

NetIQ Corp. annonce la version 1.5 de sa suite SQL Management.

Cette nouvelle version, dotée d'une fonctionnalité intégrée de concession de licences, complète l'offre faite aux partenaires de NetIQ dans le cadre du « Programme Revendeur » mis en place par la société.

Lire l'article

Interactivité entre le frontal Acces et le moteur SQL Server

par Rick Dobson - Mis en ligne le 10/06/2002

Microsoft Access 2002 est la version

d'Access livrée avec Microsoft Office XP.

nous savons tous aujourd'hui que XP est

synonyme d'expérience. Quand on utilise

des projets Access dans Access 2002,

pourrait en conclure qu'Access 2002 est

seconde tentative de Microsoft pour améliorer

l'expérience - particulièrement

pour SQL Server 2000.

L'expérience est plus conviviale et même si Microsoft continuera sans aucun doute à améliorer Access dans de futures versions, Access 2002 offre pléthore de nouvelles fonctions intéressantes si vous utilisez SQL Server 2000 ou si vous l'envisagez.

Access 2002 est compatible avec SQL Server 2000, tandis qu'Access 2000 nécessite quelques aménagements pour fonctionner avec lui. Et Access 2002 s'intègre plus étroitement à SQL Server 2000 qu'Access 2000. En outre, Access 2002 introduit plusieurs designers visuels nouveaux et améliorés et des propriétés étendues qui rendent l'utilisation de SQL Server à partir d'Access, plus puissante et plus simple. Si vous envisagez d'utiliser XML pour accomplir plus facilement certaines tâches de base de données courantes, Access 2002 propose deux nouvelles méthodes qui simplifient considérablement l'import et l'export de documents XML de bases de données SQL Server.

Un projet Access est un type spécial de fichier Access qui se connecte à une base de données SQL Server par l'intermédiaire d'une connexion OLE DB. Un projet Access facilite de nombreuses fonctions de définition de base de données SQL Server (création des bases de données, des tables, des vues et des procédures cataloguées, par exemple) et s'intègre étroitement avec les formulaires, rapports, et pages Web d'Access (que Microsoft appelle pages d'accès aux données). Les projets Access dans Access 2002 demandent quelques aménagements pour être compatibles avec SQL Server 2000. (Pour plus d'informations sur les étapes nécessaires pour l'intégration, voir l'article Microsoft « ACC2000: Incompatibility Issues Between Access 2000 Projects and SQL Server 2000 » à http://support.microsoft.com/support/kb/ articles/q269/8/24.asp.) En revanche, Access 2002 est immédiatement compatible avec SQL Server 2000 (ainsi qu'avec SQL Server 7.0 et 6.5).

Dans Access 2002, l'UI (interface utilisateur) pour le projet Access a changé pour tenir compte des fonctionnalités nouvelles et améliorées, qui font d'Access 2002 un meilleur outil de développement pour SQL Server que son prédécesseur. Les changements d'UI sont évidents dans les options de menu, dans les options proposées dans la fenêtre Database, et dans les concepteurs visuels pour les tables, les procédures cataloguées, et les UDF (userdefined functions).

Lire l'article

Sauvegarde et restauration avec Split Mirror

par Ron Talmage - Mis en ligne le 10/06/2002

SQL Server 2000 peut sauvegarder de

très grandes bases de données (VLDB,

very large databases) rapidement et

sollicitant très peu le serveur de base

de données. Mais en restaurant à partir

de ces sauvegardes, on risque de réduire

la disponibilité de la base de données.

En effet, l'un des principaux inconvénients de la restauration d'une VLDB est de la rendre indisponible pendant cette opération, c'est-à -dire pendant plusieurs heures. Pour résoudre le problème de l'indisponibilité de la base de données pendant une restauration, Microsoft s'est unie avec trois importants fournisseurs de SAN (Storage Area Network) - Compaq, EMC, et Hitachi Data Systems (HDS) - pour permettre la sauvegarde et la restauration en mode split-mirror. La restauration split-mirror peut se faire en quelques secondes, réduisant donc considérablement le temps d'indisponibilité de la base de données. Pour tous ceux qui veulent une grande disponibilité de la base de données et ne peuvent pas se permettre le temps d'interruption qu'impose la restauration, la technologie split-mirror offre une solution simple fondée sur le hardware.

Toutes les éditions de SQL Server 2000 possèdent la fonction splitmirror. Contrairement à l'interface de sauvegarde et de restauration bien connue de SQL Server 2000, le procédé split-mirror a besoin de matériel spécialisé et de logiciel tierce partie. Pour effectuer une sauvegarde ou une restauration split-mirror, il faut stocker le contenu de la base de données sur des jeux de lecteurs en miroir, en configuration SAN. Les opérations de sauvegarde et de restauration se déroulent dans le sous-système de stockage sur disque, et donc concernent peu le serveur de base de données SQL Server 2000.

Les deux types de sauvegarde diffèrent également par leur mécanismes sous-jacents. Dans une sauvegarde SQL Server 2000 classique, SQL Server écrit des pages de données sur l'unité de sauvegarde, qui peut être un fichier disque ou un lecteur de bande. En revanche, dans une sauvegarde splitmirror, SQL Server laisse au logiciel et au matériel du fournisseur du sous-système disque la responsabilité du stockage des données.

La sauvegarde split-mirror préserve la disponibilité de la base de données car elle la sauvegarde en quelques secondes. On peut donc se permettre des sauvegardes plus fréquentes. Et la restauration d'une base de données à partir d'une sauvegarde split-mirror est tout aussi rapide. La sauvegarde split-mirror permet pratiquement de se dispenser des ressources du serveur de base de données pour cette opération. De plus, on peut initialiser un serveur secondaire beaucoup plus rapidement qu'avec la méthode de sauvegarde et de restauration SQL Server standard.

Mais n'oubliez pas que la sauvegarde split-mirror demande du matériel et du logiciel spécialisés. Il faut que la base de données soit stockée sur un sous-système disque avec miroir - en principe RAID 10 sur un SAN. En outre, elle nécessite un utilitaire logiciel de gestion de volumes spécialisé pour communiquer avec SQL Server 2000. Il faut donc mettre en balance les avantages de la technologie split-mirror et le coût du logiciel et du matériel système disque qui l'accompagnent.

Lire l'article

Toujours plus sur SQL Server

Trucs et astuces pour SQL Server : Créer une propriété étendue dans SQL Server 2000, Extraire certaines lignes dans un resulset, Se connecter programmatiquement avec l’authentification Windows, Eviter d’utiliser datetime comme clé primaire, Capturer une trace SQL, Changer l’ordre de tri dans SQL Server 7.0, Détacher et rattacher des bases de données, Présenter la taille de colonne d’une table ...

Lire l'article

Log Shipping dans SQL Server 2000 (Partie II)

par Ron Talmage - Mis en ligne le 29/04/2002

Quand votre serveur de base de données de production s'arrête - pour cause de maintenance programmée ou d'événement inattendu - il faut être sûr que la base de données est intacte sur un serveur standby. Une opération log shipping bien conçue, qui transfère les journaux de transactions d'une base de données du serveur primaire sur un serveur standby, peut vous procurer cette confiance ...SQL Server 2000 Enterprise Edition et SQL Server 2000 Developer Edition supportent log shipping comme un utilitaire Enterprise Manager intégré. Le Microsoft SQL Server 2000 Resource Kit est livré avec un ensemble de procédures cataloguées non supporté pour log shipping dans d'autres éditions de SQL Server 2000 (pour plus de détails, voir l'encadré « Log Shipping simple dans SQL Server 2000 Standard Edition »), et le Microsoft BackOffice Resource Kit (BORK) 4.5 offre une méthode non supportée de log shipping pour SQL Server 7.0. Dans l'article « Log Shipping dans SQL Server 2000, 1ère partie », j'ai décrit comment installer, reconfigurer et superviser log shipping. Dans cet article, nous allons voir comment changer les rôles des serveurs primaire et secondaire, comment inverser complètement leurs rôles, et où placer le serveur moniteur pour qu'il soit le plus utile possible.

Les plus consultés sur iTPro.fr

- Les entreprises n’ont plus le luxe d’expérimenter l’IA

- Le changement, moteur d’engagement au travail

- Cloud 2026 : 5 tendances à anticiper pour les PME françaises

- Les DSI français face au défi de l’IA : ambitions élevées, marges de manœuvre limitées

Articles les + lus

L’essor de l’IA propulse les cyberattaques à des niveaux records

Face aux ransomwares, la résilience passe par les sauvegardes immuables

Les 6 tournants qui redéfinissent l’IA en entreprise

Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques

Une menace à 1 milliard d’euros : le gouffre de la fraude e-commerce en France

À la une de la chaîne Data

- L’essor de l’IA propulse les cyberattaques à des niveaux records

- Face aux ransomwares, la résilience passe par les sauvegardes immuables

- Les 6 tournants qui redéfinissent l’IA en entreprise

- Infrastructures IT : 5 leviers concrets pour éviter les impasses technologiques

- Une menace à 1 milliard d’euros : le gouffre de la fraude e-commerce en France