Installations sans assistance : toujours trop difficile

Les nouveaux outils de déploiement de Windows 2000 sont une nette amélioration

par rapport à Windows NT 4.0. Mais ils ne sont toujours pas parfait et par trop

limités.

Plusieurs fois par an, je nettoie complètement le disque dur de mon système et

je réinstalle mon OS et mes applications en partant de zéro. J'aimerais pouvoir

automatiser complètement ce processus mais ceci est généralement impossible. Il

est certes devenu facile d'utiliser un script pour installer un OS, mais l'installation

des applications et le tuning nécessaire pour adapter les applications et en tirer

le meilleur sont difficiles, voire impossible à scripter.

Le Graal de la configuration - appuyer sur une touche, aller faire un tour et

revenir une heure après pour retrouver un clone fraîchement installé de mon ancien

système - est toujours hors de portée. Comme Perceval, j'ai parfois l'impression

de m'approcher du Graal, mais de ne pas pouvoir le saisir. Un petit effort cependant,

et je pense qu'il serait possible d'avoir un service de configuration portable

et ne nécessitant pas d'intervention.

Les outils de clonage traditionnels tels que Norton Ghost de Symantec, les Services

d'installation à distance de Microsoft ou Drive Image Pro de Power Quest sont

utiles, mais ces utilitaires réalisent le clonage en sauvegardant des images de

plusieurs Gigaoctets de données inutiles. Utiliser un outils de clonage traditionnel

manque cruellement d'élégance car mes configuration sont relativement simples,

ne nécessitant que quelques Kilooctets et non plusieurs Gigaoctets.

De quelles informations a-t-on besoin pour installer un OS et quelques applications

si l'on part du principe que les installation se feront via le réseau et que les

fichiers d'installation soient sur le serveur ? Il faut tout d'abord savoir quel

serveur et quel partage contient les fichiers d'installation et disposer d'un

profil et d'un mot de passe qui permette l'accès à ce partage. Vous devez connaître

la commande (et ses paramètres) qui lance l'installation. Lorsque l'on installe

un OS, le système pose généralement quelques questions. Vous devez donc stocker

quelque part les réponses à ces questions, comme lorsque l'on prépare un script

d'installation. Enfin, vous devez disposer de ces informations pour toutes les

applications à installer.

Identification des données

21st Century Software annonce Vital File Identification for AS/400 (VFI/400), utilitaire qui identifie les données des applications critiques, vérifie la sauvegarde de chaque objet et fournit des rapports sur les fichiers.

Ce produit contrôle également les fichiers critiques, automatise la sauvegarde et peut restaurer automatiquement les séquences.

Lire l'article

Le iSeries serveur de réseau

par Mel Beckman

Tout le monde reconnaît que le iSeries est un serveur d'applications solide, performant,

évolutif, très fiable, et qui coûte relativement peu cher tant pour les applications

de type 5250 que pour les applications intranet et extranet. Mais on ignore peut-être

encore que le iSeries est aussi un serveur de réseau efficace pour gérer toutes

sortes de travaux courants, surtout dans les grandes organisations.

Tous ces avantages : performances, évolutivité, fiabilité, et bon rapport qualité/prix

sont tout aussi valables pour les fonctions réseau. De plus, certains services

réalisables sur le iSeries ne le sont sur aucune autre plate-forme.

La V4R5 de l'OS/400 contient le support nécessaire aux fonctions suivantes : serveur

de sessions, accès en réseau aux bases de données, hébergement Web, serveur SMB,

partage de fichiers NetWare, imprimante TCP/IP, accès au répertoire LDAP, serveur

DHCP et serveur de noms (DNS).

Afin d'enrichir encore le système, la V5R1 va permettre au iSeries d'accueillir

Linux, un système d'exploitation complètement différent (cf. notre rubrique IBMologie,

dans ce même numéro). Une bonne connaissance des avantages du serveur iSeries

ainsi que des capacités des différentes fonctions de l'OS/400 donnent une bonne

idée de l'avenir de ce serveur au sein du réseau.

">

">

Les outils du dossier Support Tools

par Michael Otey

Tirez parti des outils natifs du système d'exploitation

Tout comme le "Microsoft Windows 2000 Resource Kit", le dossier Support Tools

contient un ensemble d'utilitaires de nature à vous aider à gérer votre réseau

et à résoudre d'éventuels problèmes. Mais le dossier Support Tools diffère du

kit de ressources en ceci que Support Tools est natif au système d'exploitation,

et n'est pas vendu séparément. Dans le top 10 ci-dessous, je vous fais part de

mes 10 outils favoris, que vous trouverez sur le cédérom Windows 2000, dans le

répertoire /support/tools.

Installation d’une nouvelle release, première partie : planifier la réussite

par Gary Guthrie

La planification est le meilleur remède préventif pour garantir une installation

en douceurUn jour ou l'autre, il faut installer sur l'AS/400 une nouvelle release de l'OS/400

ou de nouveaux logiciels sous licence. Cette opération est " un jeu d'enfant "

par rapport à ce qu'il fallait faire, il y a quelques années, sur les premiers

modèles d'AS/400. Il n'est plus question de faire plus d'une dizaine d'IPL pour

boucler l'installation. Aujourd'hui, pour charger une nouvelle release du système

d'exploitation, on peut soit recourir à l'installation automatique, soit effectuer

une installation manuelle, avec normalement un seul IPL dans les deux cas.

Voici un guide pas à pas pour planifier et installer une nouvelle release de l'OS/400

et de nouveaux logiciels sous licence. Dans cet article, qui est une première

partie, je couvre les tâches de planification indispensables à accomplir avant

le jour de l'installation. La deuxième partie décrira les différentes tâches le

jour de l'installation et le processus d'installation lui-même.

Migrer de IIS 4.0 à IIS 5.0

Par Brett Hill

Toutes les mises à niveau du serveur web Microsoft semblent s'accompagner du passage à un nouvel OS. Il n'est donc pas étonant que tant d'ateliers Microsoft IIS 4.0 veuillent garder le status quo. Cependant, la version 5.0 semble présenter certains avantages ...

Tout d'abord, IIS 5.0 n'est plus un territoire inconnu. La version a fait ses preuves face à de gros volumes dans des entreprises comme Microsoft, Dell, Nasdaq et Ford Motor. Ensuite, IIS 5.0 est plus sûr et plus stable (particulièrement après l'installation de IIS 5.0 Service Pack 2 - SP2), plus rapide, et plus riche en fonctions que IIS 4.0. Enfin, comme IIS 5.0 ne fonctionne que sur Windows 2000, en migrant on obtient aussi les avantages de cet OS, du point de vue sécurité et stabilité. Quatrième et dernier point - et le plus déterminant - Microsoft ne va pas maintenir le bateau à l'arrêt pour vous : elle a fixé le cap sur IIS 6.0. Bien sûr, vous pourriez garder l'installation IIS 4.0 jusqu'à ce que les packs de service IIS 6.0 commencent à apparaître, mais en retardant ainsi la migration, le saut technologique sera plus important et compliquera les choses. (Pour un aperçu de quelques-unes des améliorations de IIS 6.0, voir l'encadré intitulé « IIS 6.0 : la prochaine génération »). Il vaut donc mieux passer dès à présent à IIS 5.0 et simplifier ainsi le passage ultérieur à IIS 6.0.Des études menées par Netcraft ont révélé que, bien que des milliers d'organisations utilisent encore IIS 4.0, le nombre de sites Web actifs qui utilisent IIS 5.0 sur Win2K a augmenté. Si votre site envisage une migration, il semble que le moment soit venu. Ceux qui se posent des questions sur le passage de IIS 4.0 à IIS 5.0 trouveront des réponses dans l'encadré « Questions fréquentes (FAQ) sur la migration d'IIS ».

Une fois la décision de basculement prise, il faut choisir une stratégie de migration (c'est-à -dire une mise à niveau sur place ou une mise à niveau par migration). Il faut aussi analyser les avantages et les inconvénients des diverses méthodes de migration d'une machine Windows NT sous IIS 4.0 à une machine Win2K sous IIS 5.0. Il faut réfléchir à tous les aspects de la migration, y compris la transition des utilisateurs et des groupes, le contenu Web (c'est-à -dire les fichiers HTML, les ASP (Active Server Pages) et les fichiers graphiques que le serveur Web délivre), la structure du serveur Web, les bases de données IIS, les certificats, et les applications Web. Pour conserver la maîtrise de la migration, il faut bien connaître les idées reçues erronées et les problèmes potentiels.

Lire l'article

Java et IFS

par Dan Darnell

Ceux qui développent des applications Java pour l'AS/400 rencontrent souvent des liens inextricables entre Java et les systèmes de fichiers stream dans IFS (Integrated File System). Pour commencer, dans les répertoires d'un système de fichiers stream, on stocke les fichiers source et de classes Java. IBM utilise aussi généreusement les systèmes de fichiers stream, en stockant le code d'appui pour l'ADK (AS/400 Developer Kit for Java). Bien qu'IFS soit une ombrelle recouvrant de nombreux types de systèmes de fichiers AS/400 et iSeries, le terme « IFS » désigne ici les systèmes de fichiers root (racine) et QOpenSys. Ce sont des systèmes de fichiers de type stream, plutôt que de type enregistrement ou base de données, avec des structures de répertoire hiérarchiques (pour un exemple de structure de répertoires, voir l'encadré « Fonctions des systèmes de fichiers root et QOpenSys »).

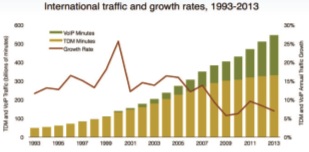

Mesure des performances sur Internet

par Sean Daily

Des lecteurs me demandent souvent quels sont les meilleurs outils et les meilleures méthodes pour mesurer les performances d'une connexion ISP ...

Des lecteurs me demandent souvent quels sont les meilleurs outils et les meilleures méthodes pour mesurer les performances d'une connexion ISP : par modem à 56 Kbps, RNIS, T1, Frame Relay, DSL (Digital Suscriber Line), modem-câble, sans fil et satellite. Ces questions viennent aussi bien de grands comptes que de PME ou SOHO (small office/home office), qui recherchent des moyens d'effectuer des tests de mesure (benchmarking) sous Windows 2000 Professional. J'ai eu récemment l'occasion de procéder à des tests de performances sur Internet sur mon propre système Win2K Pro pendant un changement de mode de connexion à Internet.

Retrouvez les figures explicatives dans l'édition papier de cet article

Lire l'article

Trois principes fondamentaux pour les performances d’Exchange Server

Les éléments fondamentaux : le matériel, la conception et le fonctionnement.Le travail d'un administrateur Microsoft Exchange Server consiste essentiellement à faire passer les messages, à maintenir le système en état de fonctionner et à donner aux utilisateurs l'impression qu'Exchange Server est fiable à 100 pour cent. Pour atteindre ces objectifs, il faut se concentrer sur plusieurs éléments fondamentaux pour les performances : le matériel, la conception et le fonctionnement, et ce, pour toutes les organisations Exchange Server, qu'il s'agisse d'Exchange Server 2000 ou d'Exchange Server 5.5. Un matériel fiable et adéquat est essentiel pour les performances d'Exchange Server, mais la conception dans laquelle il se place et la manière dont on l'utilise, sont tout aussi importantes pour atteindre durablement des performances maximales.

Lire l'article

La Lloyds Bank, l’AS/400 et Java

La veille technologique : un credo quotidien pour cette banque Suisse d’origine anglaiseA Genève, la Lloyds Bank est située sur la rive gauche du Rhône, au lieu même où ses eaux quittent le lac Léman pour couler vers la Méditerranée. Pendant 15 ans, mon bureau surplombait le même bras du Rhône; je ne connaissais pas la Lloyds Bank même si je la voyais tous les jours. Aujourd’hui, j’ai fait connaissance.

Lire l'article

Le groupe Bastide externalise son ERP

La branche Electronique et Mécanique du groupe Bastide a basculé son système d'information sous SAP/R3. Manque de ressources informatiques en interne, volonté de se reposer sur un prestataire de confiance : autant de raisons qui ont poussé la PME à externaliser son projet ERP de bout en bout.

Société brestoise employant 850 personnes, le groupe Bastide exerce deux activités principales : la réparation navale et la construction industrielle. Pour s’ouvrir à de nouveaux marchés, l’entreprise se devait de posséder un système d’information performant, permettant de répondre aux attentes de ses clients. C’est la raison pour laquelle elle a confié à Syseca, filiale de Thomson-CSF, la refonte de son système d’informations autour du progiciel de gestion intégré (ERP pour Enterprise Resource Planning) SAP R/3. Au niveau de la division Electronique et mécanique du groupe, ce sont ainsi près de 40 personnes des services commerciaux, administratifs et de gestion de la production qui sont concernées par cette refonte informatique. A terme, le nombre d'utilisateurs potentiel devrait atteindre 250. Chez Bastide, le choix du progiciel SAP/R3 s’est effectué tant pour sa capacité à répondre aux besoins de la PME que pour son fonctionnement intégré et modulaire. La nouvelle plate-forme sera déployée pour la comptabilité, le contrôle de gestion, les achats et stocks, la gestion de production et la gestion commerciale par projet. L'ensemble représente plusieurs milliers de références manipulées quotidiennement. " Entre la première étude réalisée au début de l’été 1998, et un démarrage de l’exploitation prévu pour l’été suivant, le projet est actuellement dans une phase de prototypage de la fonction finance " explique Christine Marias, contrôleur de gestion et responsable du projet. Et d’ajouter : " Nous n'avons pas encore pris le module de ressources humaines. Quant à la gestion de la paie, elle sera basculée ultérieurement, certainement à l'occasion de l'intégration de l'activité réparation navale.

Le groupe Bastide a souhaité se reposer au maximum sur des compétences extérieures pour l’implémentation du progiciel.

Lire l'article

HP OpenView network Node Manager 5.02 pour Windows NT

Avec OpenView Network Node Manager 5.02 pour Windows NT de Hewlett-Packard, Windows NT bénéficie de la puissance de l'outil vedette d'administration de réseau pour UNIX de HP, agrémenté d'une nouvelle interface. OpenView Network Node Management (NNM), qui appartient à la famille des produits d'administration de systèmes et de réseaux HP OpenView, réalise le mapping et la surveillance des composants adressables IP IPX d'un réseau (par exemple ordinateurs, routeurs et switches, hubs). L'affichages des recherches approfondies du logiciel comporte des icônes d'état codées en couleur et des seuils de notification d'événements paramétrables, qui permettent de surveiller facilement votre réseau. Pour en savoir plus sur les mises à jour du logiciel, lisez l'encadré " Network Node Manager 6.0 ".

Lire l'article

Simplifier les mises à jour avec les MODS

par Jef Sutherland

Dans le numéro de janvier 2001 de Systems JOURNAL, j'expliquais le principe de

base de l'utilisation de MODS (Multiple Occurrence Data Structures) dans les applications

RPG III. Aujourd'hui, j'approfondis davantage ces MODS, et montre comment les

utiliser pour simplifier les opérations de mise à jour dans des applications interactives.Mon application interactive met à jour un enregistrement dans un fichier. Je suis

quatre étapes de base (en excluant la recherche des erreurs) :

Administrer Exchange 2000 (2eme partie)

par Tony Redmond

Dans la première partie de cet article, parue le mois dernier, nous avons vu que

Microsoft Exchange 2000 Server avait adopté le framework de la MMC (Microsoft

Management Console) et nous avons décrit l'interaction entre Exchange 2000 et

Active Directory de Windows 2000. Nous avons également examiné la division des

tâches de gestion du serveur, effectuées par Exchange 2000 au moyen des extensions

de la console standard Utilisateurs et ordinateurs Active Directory de la MMC.

Toutes les notions mentionnées dans cette introduction constituent des bases solides

pour le fonctionnement des serveurs Exchange 2000 et préparent à votre tâche suivante

: maintenir le fonctionnement de toutes les machines Exchange 2000. Dans ce nouvel

article nous allons voir comment surveiller les serveurs et quel type d'informations

d'état on peut espérer recueillir des composants avec un serveur en bonne santé.

Nous présenterons également certains prestataires WMI (Windows Management Instrumentation)

qui permettent l'accès aux données Exchange 2000.

Comprendre les raisons des plantages

par Mark Russinovich

Même si Windows 2000 est en net progrès par rapport à Windows NT 4.0 sur la stabilité,

vous pouvez encore subir des plantages. L'analyse des fameux "écrans bleus" rencontrés

en cas de défaillances peut vous éviter certains crashes ou des heures de réinstallation.Indiscutablement, Windows 2000 apporte à Windows un niveau de fiabilité inconnu

jusqu'ici. Avec la réécriture par Microsoft du code de base du système d'exploitation,

afin de traiter les situations inhabituelles, l'énorme effort de test entrepris

par l'éditeur, et l'introduction du nouvel outil DriverVerifier, les écrans bleus

vont se raréfier dans les systèmes Windows 2000. Mais beaucoup d'entreprises dépendent

encore largement de Windows NT 4.0. De plus, bien que les pilotes de périphériques

accompagnant Windows 2000 subissent des tests complets à charge élevée, ainsi

qu'une validation de conformité pour obtenir la certification WHQL (Windows Hardware

Quality Labs) de Microsoft, des bugs non détectés peuvent encore se produire.

En outre, si des applications contenant des pilotes non destinés à du matériel,

par exemple des détecteurs de virus, des utilitaires de gestion de quotas, ou

des progiciels de chiffrements, sont installées, le système Windows 2000 peut

se retrouver avec des drivers n'ayant pas subi les tests WHQL, même si la stratégie

de signature des drivers du système est configurée pour empêcher les drivers non

testés. Ainsi, même s'ils vont se raréfier dorénavant, les écrans bleus peuvent

malgré tout encore surgir occasionnellement et, dans ce cas, les informations

nécessaires pour les analyser prendront toute leur importance. La différence est,

dans ce cas, entre quelques minutes pour désinstaller une application ou plusieurs

heures pour réinstaller complètement le système d'exploitation.

Beaucoup d'administrateurs systèmes s'abstiennent d'explorer les options de vidage

sur incident de Windows 2000 et Windows NT 4.0, estimant leur utilisation trop

complexe. Bien que la documentation de Microsoft sur le débogage se soit améliorée

l'an dernier, elle reste tout de même orientée vers les développeurs de pilotes

de périphériques. Mais même si un vidage sur incident sur cinq seulement contient

des informations utiles, il vaut vraiment la peine d'en savoir un peu plus sur

l'analyse du vidage sur incident.

Cet article facilitera l'apprentissage de cette fonction. Il commence par les

bases de configuration d'un système pour sauvegarder un vidage sur incident en

cas de plantage du système, puis explique comment se procurer les outils nécessaires

pour examiner un vidage sur incident, et se termine par des astuces pour glaner

les informations utiles, sans oublier la présentation d'un outil d'analyse de

vidage automatisée en constante évolution, Kanalyse (Kernel Memory Space Analyzer).

Quelques canevas d’utilisation des LOB SQL pour programmeurs RPG IV

par Paul Conte

SQL/400 prend en charge les grands objets (LOB, binary large objects) binaires

et caractères. En utilisant des types de colonnes LOB, on peut stocker des données

sous forme de documents complets, d' images et d' enregistrements sonores dans

SQL/400.La technique des LOB présente un avantage déterminant : une valeur de colonne

LOB peut atteindre 15 Mo, tandis que les autres types de colonnes chaînes (de

caractères par exemple) sont limités à 32 Ko. Pour connaître une autre manière

de traiter ce type de données, voir l'article " Quelques canevas d'utilisation

des DataLinks SQL pour programmeurs RPG IV ".

Pour pouvoir accéder à des colonnes LOB, les programmes RPG IV exigent des techniques

de coding spéciales. Comme la documentation existante n'est pas très claire, cette

fonction n'est pas souvent mise en oeuvre dans les applications. Cet article permet

de prendre un bon départ dans l'utilisation des LOB. Je fournis un " canevas "

simple pour les quatre principales techniques de programmation LOB et un modèle

de code à dupliquer dans les programmes RPG IV mis en oeuvre.

Pour pouvoir accéder à des colonnes LOB, les programmes RPG IV exigent des techniques de coding spéciales

Une solution fax simple et facile

par Ken Dalton

Un système intégré à OS multiples rend la télécopie aussi facile que l'impression

Notre site a récemment mis en oeuvre un service de télécopie automatisé en temps

réel, transparent pour les utilisateurs. Il nous fallait un fournisseur de solution

fax capable de traiter notre volume (nous faxons plus de 25.000 rapports par mois,

chacun contenant jusqu'à sept pages, de format 21,6 x 28 cm) et suffisamment souple

pour personnaliser les application selon les besoins. Pour chaque fax envoyé,

les données doivent traverser trois systèmes fonctionnant sur le réseau :

- Le premier système exécute le logiciel applicatif clinique Meditech Client Server

5.2 avec un système d'exploitation Microsoft NT 4.0.

- Le deuxième système exécute un logiciel applicatif financier sur un AS/400 720e

avec la V4R4 de l'OS/400.

- Le troisième système exécute la version 2.2 du logiciel Faxstar sur un Faxstar

Open System PC Server.

Il fallait donc un moyen de transmettre les données des rapports au travers

de ces trois systèmes, sans aucune intervention des utilisateurs.

Le système NT crée les rapports en utilisant soit un générateur de rapports propriétaire

appelé NPR Report Writer soit Microsoft Word. L'AS/400 reçoit les données des

rapports depuis le système NT et les utilise pour formater les informations pour

le système de télécopie. Ce dernier traite les rapports convertis par l'AS/400

et procède au traitement des fax. Il fallait donc un moyen de transmettre les

données des rapports au travers de ces trois systèmes, sans aucune intervention

des utilisateurs.

Comme il était impossible de modifier le logiciel sur le système NT, la tâche

s'avérait compliquée. En modifiant l'application nous-mêmes, nous transgressions

le contrat souscrit avec le fournisseur et avions un produit hybride. Heureusement,

grâce à la robustesse et à la souplesse de nos applications logicielles et du

système d'exploitation de l'AS/400, nous avons pu utiliser les services de communications

TCP/IP pour résoudre notre dilemme et préserver l'intégrité du logiciel applicatif

clinique NT.

Linux à l’assaut de l’informatique embarquée

par René Beretz

Linux apparaît parfois là où on l'attend le moins, comme dans les systèmes embarqués.

Et d'après les spécialistes, ses perspectives d'évolution sont très importantes

dans ce domaine

Très largement répandus mais invisibles de l'utilisateur, les logiciels embarqués

jouent un rôle fondamental dans de nombreux systèmes. Intégrés depuis longtemps

dans les systèmes spatiaux, les systèmes de contrôle et de navigation aéronautiques,

les processus industriels, ils font désormais leur apparition dans les appareils

de la vie courante : automobiles, téléphones portables, distributeurs de billets,

machines à laver, photocopieurs.

Les systèmes embarqués comportent très souvent des caractéristiques temps réel,

c'est-à -dire une capacité à réagir dans un temps limité, parfois très court, à

certains événements. Cet aspect essentiel détermine l'adéquation du système à

son objectif : faute d'obéir à ces règles, le système est en erreur, ce qui peut

aller jusqu'à mettre en danger des vies humaines. D'autres exigences peuvent se

rajouter, comme la taille réduite de la mémoire et la garantie de maintenance

à long terme des applications et des outils sous-jacents.

Les exécutifs spécialisés propriétaires qui répondent à ces besoins induisent

une dépendance forte

Des éditeurs spécialisés se sont imposés dans ce qui était jusqu'ici une niche,

d'où l'existence d'une pléthore de systèmes d'exploitation temps réel incompatibles

les uns avec les autres. Les exécutifs spécialisés propriétaires qui répondent

à ces besoins induisent une dépendance forte, des coûts de développement et de

maintenance élevés et une spécialisation à outrance des compétences.

Pour leur part, les systèmes d'exploitation généralistes ne répondent pas aux

contraintes des systèmes embarqués et temps réel. Des travaux destinés à les adapter

à ces contraintes spécifiques sont en cours depuis de nombreuses années. C'est

maintenant au tour de Linux d'entrer dans la danse.

La sécurité à la Une de l’actualité

par Isabelle Nougier

Créée en juillet 2000, la société SafeStone résulte de la reprise de l'éditeur

britannique de logiciels de sécurité DetectIT, CCT UK Limited par le groupe SoftScreen,

un autre éditeur britannique dans le domaine de la sécurité et de la supervision

des systèmes d'information sur le marché AS/400. SoftScreen étant plutôt orientée

Marketing et Commercial et CCT compétences technologiques, les deux sociétés se

sont trouvé des affinité et se sont réunies sous le nom de SafeStone.

" Nombreux sont ceux qui pensent que les hackers sont les éléments les plus dangereux

pour un système informatique. En réalité elles se trompent. Les problèmes viennent

le plus souvent de l'intérieur de l'entreprise " explique Gabor Weiner, Directeur

EMEA Europe de SafeStone, " et les conséquences de ces erreurs ou de ces problèmes

sont énormes ".

80% des violations graves de sécurité ont leur origine à l'intérieur des

organisations et les firewalls ne protègent en rien contre ces intrusions

En 1998, le CSI/FBI Computer Crime and Security a montré que sur une période de

12 mois aux Etats-Unis, 64% des entreprises avaient subi des violations de sécurité

pour un montant total des dommages estimé à 236 millions de dollars, et que 27%

de ces incidents avaient un coût unitaire supérieur à 500.000 dollars. Les statistiques

montrent également que 80% des violations graves de sécurité ont leur origine

à l'intérieur des organisations et les firewalls ne protègent en rien contre ces

intrusions internes et malencontreuses.

Fournisseur de solutions de sécurité globales pour les entreprises disposant de

systèmes informatiques hétérogènes, les produits proposés par SafeStone se concentrent

sur la gestion des accidents internes. Spécialisée sur AS/400, SafeStone se diversifie

aujourd'hui pour proposer à très court terme des produits multi-plates-formes.

| A propos de SafeStone Forte de 50 à 60 personnes en Europe continentale et d'un nombre de développeurs en perpétuelle augmentation, SafeStone compte aujourd'hui 3 divisions, réparties sur les Etats-Unis, la zone EMEA et en Grande Bretagne (qui ne fait curieusement pas partie de EMEA, que l'on appelle "Europe Continentale" chez SafeStone). Elle propose une gamme de logiciels couvrant la plus grande partie des domaines des sécurités e-business complétant les offres d'IBM. Avec le développement du e-business, les sécurités deviennent le cheval de bataille de nombreuses entreprises, et les perspectives d'avenir de SafeStone sont plutôt optimistes : le chiffre d'affaires prévu pour cette année va tourner autour de 3 à 4 millions de dollars (chiffre incluant les chiffres d'affaire de CCT et SoftScreen au premier semestre). L'objectif est de se développer en "Europe Continentale"; à cet effet, une nouvelle agence s'est récemment ouverte en France. Si au départ les produits proposés sont essentiellement basés AS/400, SafeStone se diversifie aujourd'hui et prépare des produits multiplate-formes en s'appuyant sur les produits déjà existants. |

S'agissant de sécurités sur AS/400, il ne faut par exemple pas perdre de vue que tant que les ports de communication ou point de sortie (TCP/IP, FTP, ODBC, DDM…) ne sont pas sécurisés, les utilisateurs de PC ayant accès à un AS/400 ont la possibilité d'exécuter des commandes extrêmement puissantes. Un utilisateur peut, par exemple, avoir accès à une ligne de commande depuis un PC, et même supprimer des fichiers, et ceci même s'il n'a pas accès à la ligne de commande au sein de l'application. Et c'est très simple à faire.

Aujourd'hui, les bases de données AS/400 contiennent toutes les informations de l'entreprise. Le e-business ouvrant cette base de données à tous les protagonistes, il occasionne inévitablement de réels dangers. Les préoccupations majeures des entreprises tournent donc autour des authentifications d'identités, du contrôle strict des autorisations et de l'établissement d'une politique de sécurité.

Le logiciel DetectIt proposé par SafeStone permet, entre autres fonctionnalités, de contrôler et de restreindre les différents types d'activités. Il s'agit d'une solution de sécurité d'exploitation pouvant couvrir un ensemble de systèmes IBM AS/400 interconnectés en réseau. Il assur Lire l'article

Le Service Pack 1 de Windows 2000

par Paul Thurrott

Microsoft a récemment sorti le Service Pack 1 de Windows 2000, une première collection

complète (63 Mo de données) de correctifs de bugs pour Windows 2000 Professionnel,

Windows 2000 Server, et Windows 2000 Advanced Server. La version Datacenter Server,

sortie quant à elle en même temps que le SP1, intègre déjà les correctifs de ce

dernier. Compte tenu de l'attention des entreprises pour le Service Pack 1 et

du nombre de clients qui attendent le premier Service Pack pour upgrader vers

Windows 2000, la sortie de cette mise à jour devrait provoquer une nouvelle vague

d'adoptions de Windows 2000 par les entreprises.

Les plus consultés sur iTPro.fr

- Les entreprises n’ont plus le luxe d’expérimenter l’IA

- Le changement, moteur d’engagement au travail

- Cloud 2026 : 5 tendances à anticiper pour les PME françaises

- Les DSI français face au défi de l’IA : ambitions élevées, marges de manœuvre limitées

Articles les + lus

Alliée ou menace ? Comment l’IA redessine le paysage cyber

CES 2026 : l’IA physique et la robotique redéfinissent le futur

Les 3 prédictions 2026 pour Java

Semi-conducteurs : comment l’Irlande veut contribuer à atténuer la pénurie mondiale de puces

Face à l’urgence écologique, l’IT doit faire sa révolution

À la une de la chaîne Tech

- Alliée ou menace ? Comment l’IA redessine le paysage cyber

- CES 2026 : l’IA physique et la robotique redéfinissent le futur

- Les 3 prédictions 2026 pour Java

- Semi-conducteurs : comment l’Irlande veut contribuer à atténuer la pénurie mondiale de puces

- Face à l’urgence écologique, l’IT doit faire sa révolution