Au coeur du noyau de Windows 2000

Microsoft a déclaré que Windows 2000 est la plus importante mise à niveau de toute

son histoire. Windows NT 4.0 est sorti mi-1996, et pour créer la nouvelle version

Windows 2000, Microsoft a bénéficié de l'expérience des utilisateurs et de sa

propre étude du système d'exploitation pendant trois années.

Je voudrais dissiper le mythe selon lequel le kernel de Windows 2000 est une simple

réécriture de celui de NT 4.0. Il s'agit, en réalité, d'une version tunée et peaufinée

du noyau de NT 4.0, comportant certaines améliorations significatives de zones

particulières et deux nouveaux sous-systèmes. Avec ces modifications, Microsoft

a voulu améliorer l'évolutivité, la fiabilité et la sécurité du système d'exploitation

par rapport à NT 4.0, et permettre le support de nouvelles fonctions telles que

Plug and Play (PnP) et la gestion de l'alimentation.

Dans cet article, je fais rapidement le tour des changements apportés au kernel

dans Windows 2000. Je ne parle pas des composants Windows 2000 du mode utilisateur,

comme Active Directory (AD) ou les interfaces d'administration, qui ne tirent

pas parti des changements du kernel pour leur implémentation. Je n'ai pas suffisamment

d'espace pour décrire une fonction particulière en détail, mais vous pouvez consulter

d'autres articles spécifiquement consacrés aux fonctions internes de NT.

NT 4.0 a la réputation de ne pas supporter suffisamment les montées

en charge sur les machines SMP, en particulier à plus de quatre CPU

Explorons Management Central

IBM y intègre la gestion des PTF et le packaging et la diffusion d'objets, et clarifie sa stratégie en matière d'outils de gestion système graphiques. A l'instar de différents secteurs du marché de l'AS/400, lorsqu'il s'agit de choisir une solution de gestion système dans l'offre IBM ou dans celles de ses “ Business Partners ”, le client n'a que l'embarras du choix. Le présent article a pour but de vous faire découvrir l'un des nouveaux venus dans ce domaine : Management Central. Il s'agit d'un ensemble d'outils pouvant être utilisés pour observer et surveiller plusieurs AS/400 connectés via TCP/IP. Management Central fait partie d'Operations Navigator (OpNav), qui à son tour, fait partie de la portion de Client Access livrée gratuitement. Management Central fait partie d'Operations Navigator La version originale, en V4R3, de Management Central offrait d'une part des fonctions de collecte d'informations et d'autre part, des fonctions d'affichage graphique de différents indicateurs de performances. Avec la V4R4 et la nouvelle mouture de Client Access lancée en mai 1999, IBM a élargi les fonctionnalités de Management Central. Désormais, le produit offre également des fonctions de gestion des composants matériels et logiciels, des PTF, permet de collecter des informations sur les performances, d'exécuter des commandes à distance ainsi que de distribuer des fichiers AS/400 et IFS. Entamons notre tour d'horizon en analysant la version actuelle de Management Central.

Lire l'article

Un Cerbère protège Windows 2000

Dans la mythologie grecque, Cerbère - Kerberos en anglais - est le chien à trois têtes qui garde l'entrée des enfers. La mise en oeuvre réalisée par Microsoft de Kerberos est un peu moins féroce tout de même. C'est la RFC (Request for Comments) 1510 qui définit le protocole Kerberos de base, développé au MIT comme partie intégrante du projet Athena et portant sur l'authentification des utilisateurs. Microsoft a intégré cette version de Kerberos dans Windows 2000 comme nouveau protocole d'authentification par défaut de l'OS. Dans cet article nous verrons les fonctions essentielles de l'implémentation de Kerberos par Microsoft.

Lire l'article

Comment sécuriser les réseaux NT / Unix

Bien que Windows NT et Unix aient en commun bon nombre de forces et de faiblesses en matière de sécurité, l'utilisation simultanée de ces deux OS dans le même réseau ajoute à sa complexité. Une complexité d'autant plus pesante si ce réseau mixte est connecté à l'Internet. Les administrateurs de réseaux NT et UNIX mixtes doivent donc impérativement développer et mettre en oeuvre un plan de sécurité complet. Dans un grand nombre d'organisations les plans de sécurité NT et UNIX sont inefficaces. On commet communément l'erreur de croire qu'il suffit d'installer un pare-feu et un serveur proxy pour garantir la sécurité d'un réseau. Cette mesure est importante, certes, mais elle ne représente qu'un élément d'un plan efficace. Un plan de sécurité NT et UNIX complet exige non seulement d'installer des pare-feux et des serveurs proxy, mais également de choisir soigneusement les applications, de sécuriser le serveur Web, de gérer efficacement les mots de passe et les logons, ainsi que les comptes d'utilisateurs et de groupes, de sécuriser physiquement le réseau, de garantir l'intégrité des données via des sauvegardes, et de surveiller les applications.

Lire l'article

Naviguer dans la résolution de noms ( Partie 1 )

La question le plus souvent posée aux consultants réseau est ce qui, dans la mise en réseau de Windows, pose le plus de problèmes. La réponse est sans détour : la résolution des noms, avec son indissociable cortège de maux - mauvaises performances, incapacité des clients ou des applications à se connecter aux serveurs, listes d'exploration incomplètes et obscurs messages d'erreur aux problèmes de résolution des noms d'ordinateurs en adresses IP. Pour vous aider à venir à bout de ces maladies, cet article propose une initiation à la résolution des noms, explique certaines causes, peu connues, des problèmes de résolution de noms et règle un malentendu courant sur le sujet.

Lire l'article

Mettez un tigre dans votre firewall

Indispensables pour sécuriser un réseau connecté à l'Internet, les firewalls ne suffisent plus pour garantir une protection suffisante. Ce sont en effet des systèmes statiques imposant un ensemble particulier de règles et permettant, par conséquent, à des pirates d'utiliser des paquets valides pour attaquer un réseau et en compromettre la sécurité. Pour une protection complète, surtout de Windows NT et du protocole IP, il vous faut plus qu'un simple firewall. Pour situer les problèmes potentiels, avant que des hackers (les intrus qui pénètrent les systèmes avec des intentions généralement malveillantes) ne les exploitent à l'intérieur ou à l'extérieur de votre réseau, vous avez le choix entre plusieurs outils de sécurité, tels que les scanners de ports, tests de vulnérabilité, analyseurs de journaux et autres détecteurs d'intrusion.

Lire l'article

Optimiser les performances de NTFS

Système de fichier moderne et fiable, NTFS peut être amélioré grâce au tuning et mieux adapté aux besoins propres à chaque entreprise. Cet article décrit des mesures pour évaluer et optimiser les performances des volumes NTFS.En 1993, Microsoft a lancé Windows NT 3.1 et, avec lui, un nouveau système de fichier FAT conçu pour améliorer les possibilités du nouvel OS. Conçu à l’origine par Gary Kumura et Tom Miller, membres de l’équipe de développement originale de NT, NTFS s’appuie sur la sécurité de NT pour améliorer les caractéristiques d’efficacité et de récupération de FAT.

Ces fonctions font de NTFS le système de fichier de prédilection pour les disques de grands volumes des serveurs de réseau. On trouve toujours le système FAT sur les disques de nombreux systèmes qui en ont besoin (par exemple les partitions multi OS ou les serveurs NT basés sur RISC) ; mais les limites de ce système en ont fait un canard boiteux dans l’univers NT moderne.

Si vous voulez satisfaire aux impératifs de sécurité, de performances et de capacité propres à la plupart des organisations, NTFS est le seul choix possible.NTFS est un système de fichier robuste, autocorrectif, qui offre plusieurs fonctions personnalisables ayant une incidence sur son fonctionnement dans un environnement donné.

Certains paramètres sont généraux et d’autres spécifiques à certains volumes NTFS et un certain nombre peuvent se contrôler et s’optimiser. En examinant les besoins de stockage spécifiques à un système et en adaptant ensuite les volumes NT en conséquence, il est possible d’augmenter significativement les performances de disques des systèmes. Cet article décrit plusieurs méthodes pour évaluer et augmenter les performances de NTFS.

De plus en plus évolutif :SQL Server 7.0

A l’approche de 2000, l’un des plus grands défis à relever pour Microsoft avec Windows NT est celui de l’évolutivité. C’est d’ailleurs ce challenge qui a servi de directive principale au développement de SQL Server 7.0.SQL Server 6.5 est, certes, une excellente base de données départementale, mais beaucoup d’utilisateurs savent bien, au fond, que le logiciel n’est pas suffisamment évolutif à l’échelon d’une entreprise. Voilà pourquoi beaucoup d’éditeurs de d’ERP ne supportent SQL Server 6.5 qu’à contrecœur (voire pas du tout), en ne le recommandant que pour les petites implémentations SQL Server 7.0 bouleverse radicalement la situation. Microsoft a revu le produit de fond en comble. De nombreuses améliorations architecturales ont boosté l’évolutivité de SQL Server 7.0 dans l’arène de l’entreprise. Résultat, les éditeurs d’ERP l’ont aussitôt adopté. Détaillons les principales améliorations de l’évolutivité de SQL Server 7.0.

Lire l'article

Trois façons de maigrir

Dans notre numéro de mai 1998, nous avions testé les beta 1 de Terminal Server et de MetaFrame de Citrix Systems ainsi que la MaxStation de Maxspeed pour l'article " Enfants de l'Hydre ". Depuis, les environnement NT multiutilisateurs ont évolué. Voici donc les pages " minceur " que tout bon magazine se doit de proposer pour l'été.

Lire l'article

Mesurer et administrer les performances des applications NT Workstation

Quand il s'agit d'obtenir des performances maximales de Windows NT Workstation 4.0, la première chose qui vient à l'esprit est qu'il suffit d'éliminer le shell de l'explorateur, d'utiliser une interface d'invite de commandes et de ne pas exécuter ces fichues applications graphiques. Moyennant quoi NT Workstation va décoller. C'est ce que j'appelle la " mentalité table rase ", d'ailleurs répandue chez les disciples d'UNIX, persuadés, parfois non sans raison, que les applications graphiques sont cause de ralentissement. En fait, les performances du noyau de Windows NT n'ont aucune importance, puisque Windows NT Workstation fonctionne dans un environnement graphique et exécute des applications graphiques. Dans la plupart des cas, on ne peut pas désactiver le shell de l'Explorateur Windows sans invalider la fonctionnalité du système. Il est donc temps de réexaminer d'un oeil neuf comment mesurer et gérer les performances des postes de travail Windows NT afin de profiter au maximum de cet investissement. Pour commencer, les compteurs de l'analyseur de performances permettent d'identifier les applications posant des problèmes, ce qui est un point de départ très utile. Par ailleurs, certains utilitaires du Kit de ressources de Windows NT Workstation 4.0 aident à mesurer et à surveiller les problèmes de performances.

Lire l'article

Une nouvelle étape pour le groupe RMH

La récente fusion des groupes TMA et RMH est l'occasion pour RMH de présenter sa nouvelle organisation.

Lire l'article

Commerce électronique : le marché aux puces

Beaucoup d'entreprises considèrent toujours les cartes à puce comme une technologie

futuriste. C'est peut-être le cas de la vôtre. Pour Windows 2000, en revanche,

elles sont d'ores et déjà une réalité bien actuelle, et bénéficieront donc d'un

support extrêmement intégré.

Cet article présente les cartes à puce, en expliquant leur importance et leur

fonctionnement et comment commencer à les utiliser dans Windows 2000. Nous détaillerons

plus particulièrement la configuration d'une connexion avec la carte à puce GemSAFE

de Gemplus et le lecteur GCR410. Et comme cette technologie n'est pas parfaite

non plus, nous verronségalement un certain nombre de risques qui lui sont inhérents.

Les cartes à puce permettent de créer une infrastructure à clé publique (PKI pour

public key infrastructure), laquelle facilite, à son tour, l'e-commerce. Une PKI

permet d'atteindre un niveau de confiance pour les transactions électroniques,

au moins égal à celui de l'univers du papier et de la signature manuscrite. Une

PKI peut garantir l'intégrité des messages, la confidentialité et le non-reniement.

Vous ne pouvez pas nier avoir envoyé un message, s'il est signé de votre certificat

numérique, puisque votre clé publique vérifie votre signature.

Si une clé publique vérifie avec succès une signature, la seule personne qui a

pu envoyer le message est celle qui détient la clé publique. La pierre angulaire

de la sécurité d'une PKI est que la clé privée associée à un certificat numérique

doit rester privée. Sinon, un hacker peut utiliser une clé privée pour contrefaire

facilement les transactions.

Les cartes à puce permettent de créer une infrastructure à clé publique

(PKI), laquelle facilite, à son tour, l'e-commerce

Les SAN tirent leur épingle du jeu

Récemment, Scott McNealy, PDG de Sun Microsystems, a déclaré " Le stockage n’est pas une industrie ; c’est une fonction du serveur " Pour EMC et Data General, il s’agit pourtant bel et bien d’une industrie - et d’une industrie qui marche incroyablement bien.Quand on sait que 50 % de l’investissement en infrastructure effectués par une entreprise sont destinés au stockage (certains analystes vont même jusqu’à 70 %), on comprend assez bien l’importance de ce marché. L’e-commerce, le datawarehousing, le datamining, le multimédia et les transactions OLTP consomment rapidement les ressources de stockage et pèsent lourdement sur les réseaux des entreprises.

Ces technologies contribuent aussi à susciter un intérêt pour le développement de la technologie du SAN (Storage Area Network) qui consolide et gère les données et décharge le trafic du réseau vers un sous-système.L’émergence de la technologie Fibre Channel (FC) facilite considérablement la mise en œuvre des SAN, entraînant du même coup plusieurs nouveaux acteurs sur le marché avec des offres telles que des sous-systèmes disques, des commutateurs, des interconnexions, des systèmes de sauvegarde et de récupération, des bibliothèques sur CD-ROM et des lecteurs de bandes.

Pour les constructeurs les SAN sont une aubaine, avec un marché mondial qui progressera de 4 milliards de dollars environ en 1998 à 17 milliards en 2000, selon Strategic Research. IDC prévoit pour sa part que le marché global du stockage atteindra 50 milliards de dollars en 2002 et celui du SAN 11 milliards de dollars en 2003.

L’avenir du SAN et le développement des standards FC sont inexorablement liés car Fibre Channel augmente considérablement les possibilités de connectivité des SAN et permet la distribution à distance.

Les trois organismes qui définissent les standards FC en ce moment sont Fibre Alliance, sous l’égide d’EMC, la SNIA (Storage Networking Industry Association) et l’IETF (Internet Engineering Task Force), à qui revient en dernier lieu la décision des standards qui seront adoptés. L’avenir des SAN dépend de ces organismes.

L’avenir du SAN et le développement des standards Fibre Channel sont inexorablement liés

Stockage performant des données

Pour obtenir des traitements performants, tout le monde pense à choisir un bon schéma physique pour les données d'une base. Mais il faut aussi stocker les données d'une manière acceptable pour les durées de sauvegarde, restauration et réorganisation. Voici quelques conseils. Le but de cet article est d'offrir quelques conseils en matière de sauvegarde et non de faire le tour du sujet. Nous n'y traiterons donc pas du choix des matériels (disques et streamers en mode RAID, divers types de cartouches, robots de stockage, réseaux d'accès aux données NAS/SAN et réseaux d'accès aux périphériques de sauvegarde.

Lire l'article

PPTP est-il sûr ?

Ces dernières années, les utilisateurs et les hackers ont révélé de sérieux défauts

dans l'implémentation par Microsoft de PPTP, le composant de RAS permettant d'établir

des réseaux privés virtuels. Les hotfixes de Microsoft corrigent-ils les lacunes

de PPTP ?

Les premiers grondements éloignés, annonciateurs de l'orage, se sont manifestés

en avril 1998, quand les utilisateurs ont posé des questions sur la sécurité de

PPTP dans les forums de sécurité. Ces questions étaient généralement suivies par

des descriptions d'éventuelles vulnérabilités des réseaux privés virtuels (VPN

pour Virtual Private Network).

En juin 1998, Counterpane Systems a sorti " Cryptanalysis Microsoft's Point-to-Point

Tunneling Protocol " (http://www.counterpane.com/pptppaper.html),

une analyse formelle démontrant les vulnérabilités de PPTP. Quelque temps plus

tard, L0pht Heavy Industries, (http://www.L0pht.com)

a sorti Readsmb (qui accompagne L0phtCrack 2.0), un programme renifleur capable

de déduire les mots de passe d'utilisateurs à partir des questions/réponses traversant

la plupart des réseaux NT. (Pour en savoir plus sur Readsmb, voir l'article "

Protégez vos mots de passe " de décembre 1998).

Au moment où la communauté de la sécurité révélait ces vulnérabilités, Microsoft

était en train de développer les mises à jour de la spécification PPTP et les

versions du code consécutives. En août 1998, Microsoft a sorti trois corrections

pour PPTP et d'autres mises à jour de DUN.

Les utilisateurs et les hackers ont révélé plusieurs faiblesses de PPTP compromettant

la sécurité du système

L'an dernier, on a eu beaucoup de mal à suivre l'évolution des choses tant

la confusion était grande entre les déclarations des hackers et les réponses de

Microsoft. La question de la sécurité de PPTP reste donc d'actualité. Pour répondre

à cette question, je vais détailler les faiblesses de PPTP et expliquer comment

Microsoft a réussi à les corriger avec les améliorations successives de la mise

à jour PPTP3. J'indiquerai aussi où trouver les améliorations de sécurité de Microsoft.

Le top 10 des commandes batch

Le Kit de ressources de Windows NT Server 4.0 comporte de nombreuses commandes batch. Cer article liste les dix commandes que j'utilise le plus. Il n'a pas été facile de ne choisir que dix commandes parmi les nombreux utilitaires du Kit de ressources.

Lire l'article

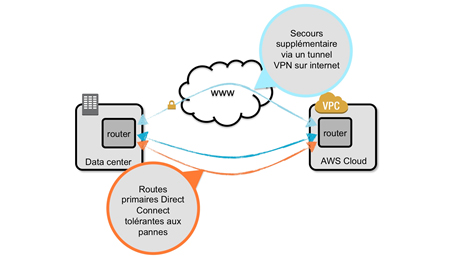

Bâtir des routages IP redondants

Le succès du commerce électronique repose largement sur le routage IP, qui achemine

les informations de l'e-business d'une entreprise à l'autre. Sans mécanisme de

routage IP redondant et à tolérance de panne, l'e-business d'une entreprise ne

peut pas survivre aux désastres (ouragans, inondations, panne d'alimentation,

interruptions de connexions Internet, défaillances hardware…), parce que l'entreprise

n'a pas d'autre méthode pour accéder à l'Internet

Pour atteindre et conserver un avantage concurrentiel en commerce électronique,

il vous faut intégrer un routage IP redondant dans votre infrastructure Internet.

Il existe divers moyens pour cela et l'un des plus courants est d'installer des

routeurs et des connexions Internet redondants. La présence de plusieurs routeurs

sur un même sous-réseau garantit la disponibilité d'une passerelle vers les serveurs

Internet en cas de défaillance de la passerelle par défaut.

De même plusieurs connexions à divers ISP (c'est-à -dire le multihoming) permettent

de disposer d'itinéraires de substitution vers l'Internet, en cas de panne d'une

liaison Internet ou d'un routeur.

Avant même l'expansion du commerce électronique, l'IETF (Internet Engineering

Task Force) avait mis au point plusieurs protocoles Internet pour le routage IP

redondant. Il s'agit du protocole FIRP (Fault Isolation and Recovery Protocol),

qui détecte les passerelles qui ne fonctionnent plus et supporte plusieurs passerelles

par défaut ; IRDP (Internet Router Discovery Protocol) ; VRRP (Virtual Router

Redundancy Protocol) et BGP (Border Gateway Protocol). FIRP, IRDP et VRRP servent

à créer la redondance des routeurs locaux et BGP la redondance des routeurs Internet.

Windows 2000 et Windows NT 4.0 supportent FIRP et IRDP, et de nombreux produits

d'exploitation et de routage Internet supportent IRDP, VRRP et BGP.

Pour inclure la fonctionnalité de routage IP redondant dans une infrastructure

de commerce électronique, il est indispensable de bien comprendre les bases du

fonctionnement de ces protocoles dans les configurations de routage IP redondantes.

Partager les connexions Internet

Le routage IP du LAN vers le WAN est un thème récurrent depuis plusieurs années.

Cet article fait le point sur les aptitudes de Windows NT à router le trafic IP.

En1992, j'ai décidé d'établir mon entreprise sur le Web. Je me suis donc adressé

à un ISP pour me procurer 256 adresses IP. L'entreprise devait héberger ses propres

serveurs Web et de messagerie et il fallait par conséquent des connexions Internet

24 x 7. Au lieu d'acheter un routeur LAN-WAN de Cisco Systems ou autres constructeurs,

je trouvai l'expérience beaucoup plus enrichissante de construire moi-même un

routeur.

Ce premier routeur devait servir à traiter OS/2 2.0 et TCP/IP pour OS/2. Dès que

Windows NT se mit à supporter le routage IP, je remplaçai OS/2 par NT. Puis je

rédigeai une série d'articles pour Windows 2000 Magazine pour expliquer comment

faire d'un système NT un routeur LAN-WAN.

es articles continuent à générer une importante quantité de courrier, décrivant

tous le même scénario et posant constamment la même question : J'ai

un ordinateur chez moi connecté à Internet par une liaison ADSL/modem câble/RNIS.

J'ai aussi plusieurs autres machines chez moi.

Comment configurer mon PC connecté à Internet pour partager sa liaison Internet

avec les autres machines ?

Après la publication des premiers articles, j'ai revu la question deux fois

- d'abord lorsque Microsoft a sorti le code de routage amélioré RRAS (dit Steelhead),

puis pour la sortie de Proxy Server 2.0. RRAS n'était pas la bonne réponse pour

les télétravailleurs, car il exigeait que chaque machine ait une adresse IP fournie

par l'ISP. Or, la création d'adresses aléatoires ne fonctionnait pas pour des

machines domestiques. Proxy Server contournait le problème mais en posait un autre

en raison des frais occasionnés - dans les 1000 dollars.

Avec Windows 98 SE ou Windows 2000 Professional, il suffit de quelques

clics de souris et de rebooter pour profiter facilement du routage

Mais avec Windows 98 Second Edition (Win98SE) ou Windows 2000 Professional,

il suffit de quelques clics de souris et de rebooter les PC pour profiter facilement

du routage. Win98SE devait être disponible au moment où vous lirez cet article

et Windows 2000 Pro et Windows 2000 Server sortiront probablement très bientôt.

Malheureusement Microsoft n'offrira pas Win98SE à tout le monde - comme les versions

OSR (Version de service OEM) de Win95, il ne sera disponible qu'avec l'achat d'un

nouvel ordinateur. Mais si vous pouvez attendre jusqu'à la sortie de Windows 2000

ou si vous achetez un nouveau PC, le routage facile c'est pour bientôt.

Au coeur de la gestion du stockage – Première partie

L'évolution de la gestion du stockage de Windows NT débute avec DOS ; le premier OS de Microsoft. Avec l'augmentation de la taille des disques durs, DOS a du s'adapter. Pour cela, une des premières décisions prises par Microsoft a été de permettre à DOS de créer de multiples partitions, ou disques logiques, sur un même disque physique.Avec l'introduction des disques logiques, DOS a pu formater chaque partition avec un type de système de fichiers différent (FAT12 ou FAT 16) et affecter à chaque partition une lettre d'unité différente. DOS 3 et 4 étaient sévèrement limités quant à la taille et au nombre de partitions que l'on pouvait créer, mais avec DOS 5, le système de partitions est arrivé à sa pleine maturité : on pouvait diviser un disque en autant de partition de quelque taille que ce fût. Windows NT a emprunté le système des partitions du DOS afin d'assurer la compatibilité des disques avec DOS et Windows 3.x, et pour que l'équipe de développement de NT puisse s'appuyer sur des composants éprouvés pour la gestion des disques.

Dans Windows NT, Microsoft a fait évoluer les concepts de base du système de partitionnement de base du DOS pour supporter les fonctions de gestion des disques des OS d'entreprise : le spanning de disques et la tolérance aux pannes. Dès la première version de Windows NT, les administrateurs système ont pu créer des volumes comprenant plusieurs partitions.

Cette possibilité permet de créer de grands volumes consistant en partitions réparties sur plusieurs disques physiques et permet la mise en œuvre de la tolérance de panne grâce à la redondance logicielle des données. Le support du partitionnement de Windows NT est assez souple pour supporter la plupart des besoins de gestion du stockage, mais ce support comporte plusieurs inconvénients. Un de ces inconvénients est que la plupart des modifications de configuration des disques nécessitent un redémarrage pour entrer en vigueur. Dans l'environnement actuel des serveurs, qui doivent rester on-line pendant des mois, voire des années, tout redémarrage (même planifié) est un problème majeur.

Autre inconvénient, le Registre de Windows NT stocke les informations avancées de configuration des disques. Ce choix a pour conséquence de compliquer le déplacement des informations de configuration lorsque l'on déplace des disques d'un serveur à un autre. Il est facile de perdre des informations de configuration lorsque vous devez réinstaller le disque. Enfin, le fait que NT exige que chaque volume ait une unique lettre d'unité dans la tranche A à Z, fixe un plafond au nombre de volumes locaux et distants qu'un utilisateur puisse créer.

Windows 2000 élimine bon nombre de limitations des tâches de gestion du stockage de NT 4.0Windows 2000 élimine bon nombre de limitations des tâches de gestion du stockage de NT 4.0 avec une nuée de nouvelles améliorations en la matière. Depuis les points de montage de volumes, qui permettent de supprimer la limite du nombre de volumes possibles, au support intégré de la migration des fichiers, en passant par le stockage hors connexion ou la gestion du stockage sans redémarrage, Windows 2000 place sa gestion du stockage à un niveau équivalent à celui des UNIX les plus évolués. Détaillons les internes de la gestion du stockage dans Windows NT et 2000.

Thorn Europhane : ERP et Terminal Server au centre du nouveau SI

Pour bâtir son nouveau système d'information multisite, le groupe Thorn a opté pour la mise en place de l'ERP Baan. Les problèmes de communications de données entre les filiales ont pu être résolus grâce à l'architecture Terminal Server/Metaframe.La décision de mettre en oeuvre une informatique de gestion commune au niveau du groupe Thorn est née il y a trois ans, et répondait à une double contrainte. D'une part, les difficultés de consolidations de chiffres, et d'autres parts les problèmes de communication entre les différentes filiales, au sein d'environnements informatiques très hétérogènes. " Il devenait primordial de mettre en oeuvre un modèle de gestion plus cohérent au niveau du groupe, de rationaliser les systèmes d'informations des différentes filiales, et faire en sorte qu'ils passent le cap de l'an 2000. " explique Gérard L'hote, directeur administratif et financier chez Thorn Europhane. C'est le progiciel de gestion intégré Baan qui sera retenu, après la phase de Business Re Engineering, pour supporter une rénovation complète du système d'information de l'entreprise : de la gestion comptable, financière, commerciale, à la gestion de production. " Nous avons fait le choix de l'ERP Baan car c'était alors, le seul produit du marché susceptible de nous aider à bâtir un système d'information multisite transfrontières, en nous apportant une réponse métier adaptée à notre problématique de GPAO. " souligne Gérard L'hote. Quant à l'intégrateur Origin, il sera chargé de la mise en oeuvre complète de l'ERP. " Origin est aujourd'hui le premier intégrateur Baan sur le marché, mais c'est aussi la seule société de services capable d'apporter une réponse internationale à notre problématique d'implémentation. " précise Gérard L'hote.

A partir du mois de juin 1998, un modèle commun d'implémentation a été choisi pour l'ensemble des pays concernés (Angleterre, Suède, France et Allemagne). A charge de ces filiales, d'adapter ensuite la solution à leurs besoins propres de gestion, via des personnalisations et des développements spécifiques.

" L'architecture AS400 nous posait de gros problèmes de communications entre sites à cause du protocole SNA "

Basée en Angleterre, l'usine de production de Spennymoor sera la première à finaliser la mise en oeuvre de la gestion de production. Elle sera suivie par son homologue allemande, qui optera pour une démarche Big Bang du fait de sa configuration multisite. La France vient quant à elle de terminer l'implémentation de la solution par la mise en oeuvre du dernier module de gestion commerciale.

Lire l'article